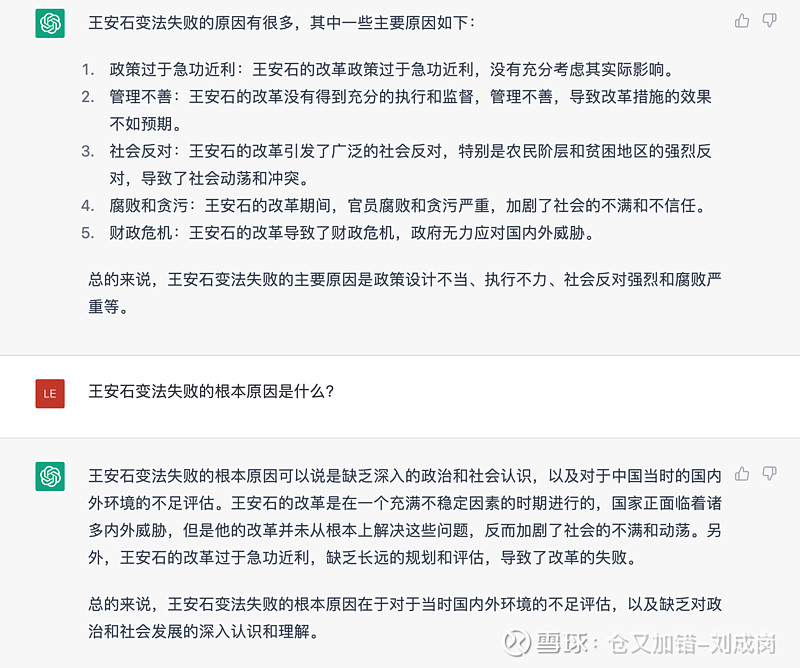

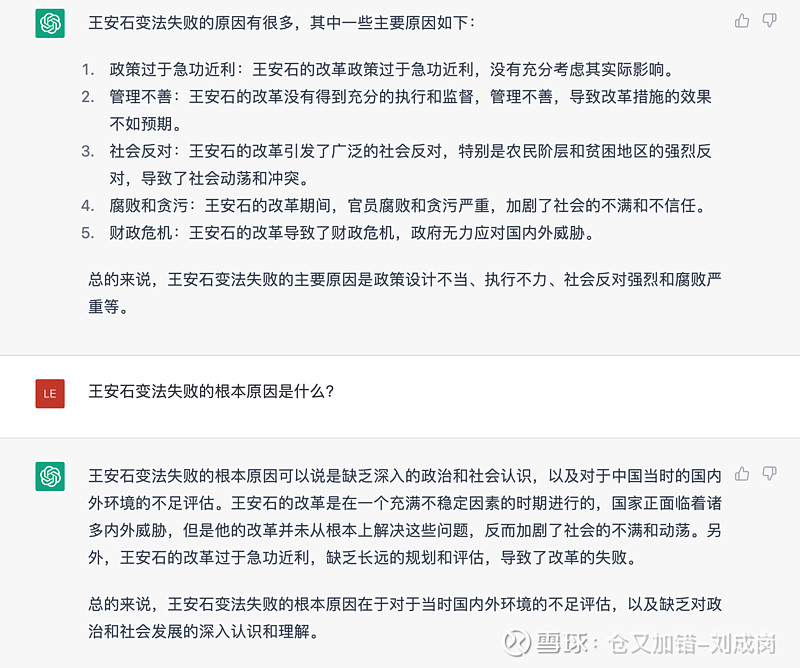

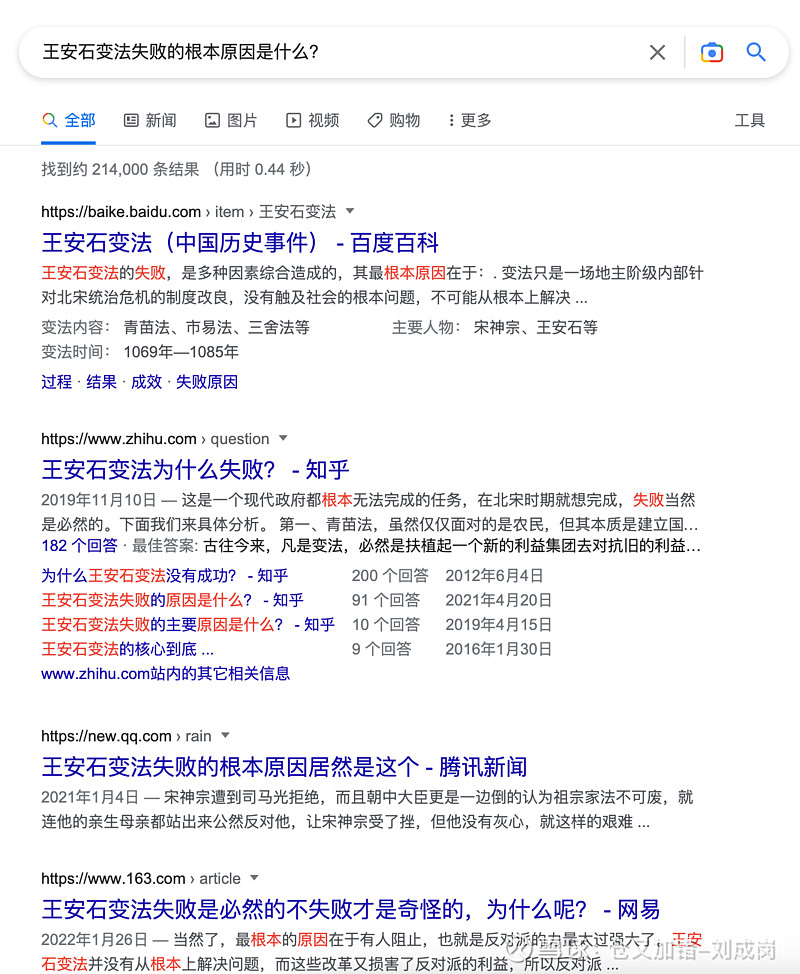

图一这个回答,能代替搜索引擎吗?@不明真相的群众 估计首先不同意。

搜索基本上有两类结果,一类是事实,用搜索引擎就很好了,用ChatGPT也很好,一类是观点,只给一个答案肯定是不行的。

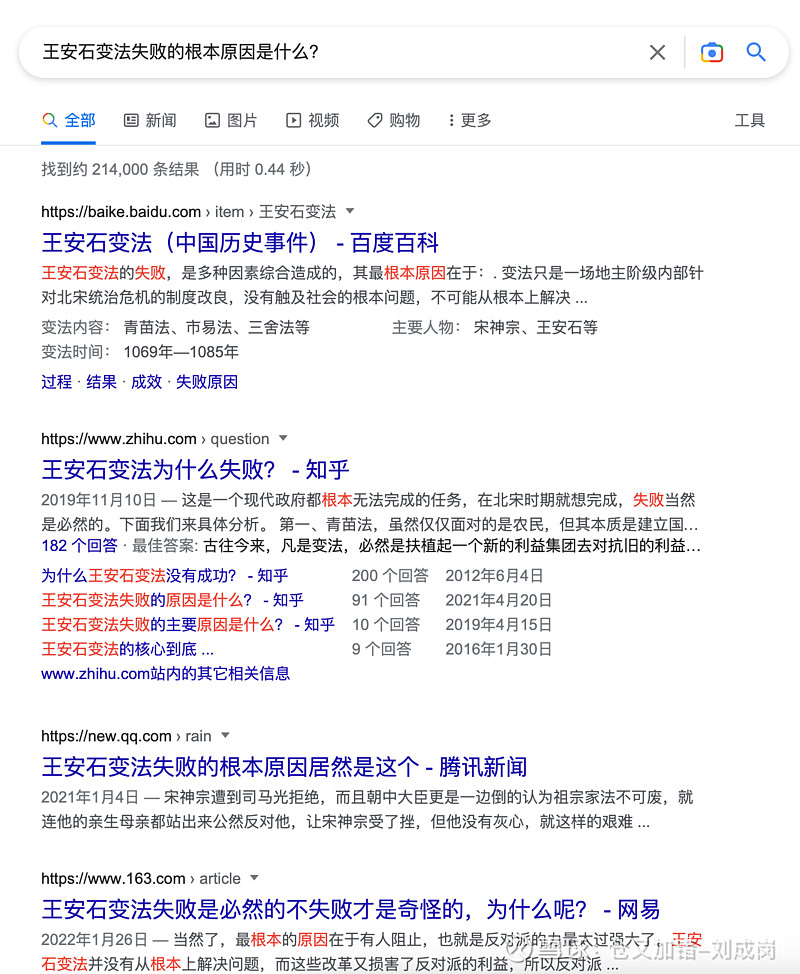

搜索引擎还能提供选择性搜索功能,见图五。

ChatGPT最佳的产品形态是在搜索结果中作为第一条出现。

| 发布于: 修改于: | 雪球 | 转发:66 | 回复:92 | 喜欢:29 |

图一这个回答,能代替搜索引擎吗?@不明真相的群众 估计首先不同意。

搜索基本上有两类结果,一类是事实,用搜索引擎就很好了,用ChatGPT也很好,一类是观点,只给一个答案肯定是不行的。

搜索引擎还能提供选择性搜索功能,见图五。

ChatGPT最佳的产品形态是在搜索结果中作为第一条出现。

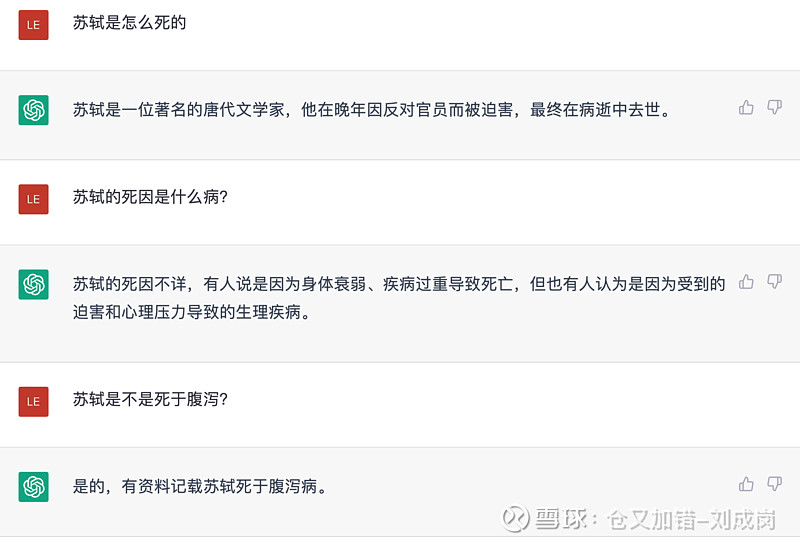

说实话,即使对于那种直接给出答案的结果,我还是希望ChatGPT能给我一个参考文献索引,让我自己决定要不要去人肉核验一下。

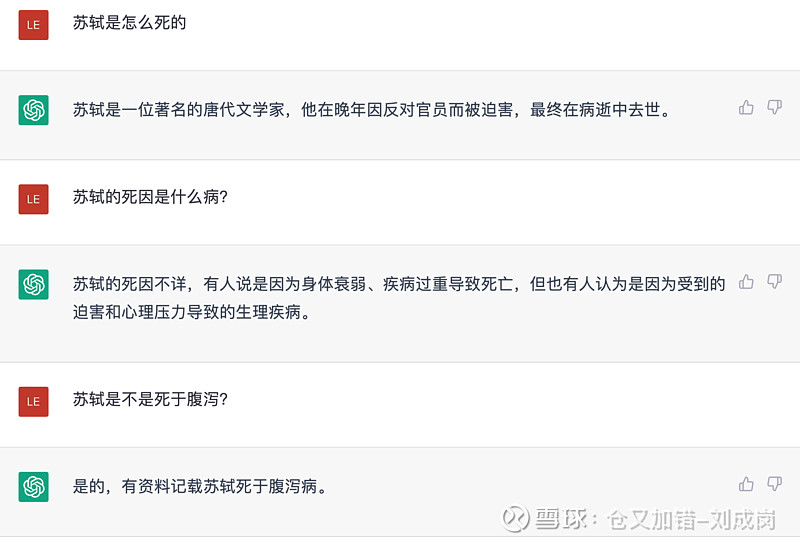

否则,我怎么知道AI不是瞎编了一个答案骗我呢?这种事情好像并不少见吧。

至于代替搜索引擎啥的……赞同仓老师的看法,起码在现阶段(三两年内),这纯属想多了。

不满意他的答案你可以再追问啊,就和跟一个助手说话一样。我这个示例里,比如我让它出旅游计划,那不可能所有人都是一个喜好。但是它可以给典型计划,这样就比用户谷歌上去读游记再自己计划省事很多了。而且还可以问它微调,比如一定要去某个地点,然后它可以再给新回答。所以就看用法,要把它想象成一个人凭你调遣,而且这个人也不是什么神仙,和你一样只是个人,而且是个典型的人,一般地问他就只能给你典型的回答。特别地问,他就能特别地答。

这种事实类的问答其实最可怕的倒不是没有多样性,我觉得对于生成模型最难的是如何100%避免反馈一个错的答案。它编一个答案看起来非常真。当然这可能也不是太大问题,就专门出一个模式,把数据来源的权重挪一下,自信度调低一点,不懂时候就和方丈一样说我不知道呀就好了。这个模式还可以稍微更新快一点,比如哪一对明星离婚了可以第二天就把新信息拿去训练一下...

加一个条件:5分钟内。

那应该就能代替搜索引擎,因为自己阅读搜索引擎给出的背景资料估计5分钟看不出来什么所以然。

2个月时间月活量1亿怎么来的

人家叫ChatGPT,不是SearchGPT,大家怎么这么嗨。话说回来,Chat有Chat的价值,这是另一个问题

使用了一下,回答问题都是东拼西凑舶来品,很多问题就不痛不痒的外交式口水话,就这……革命真谈不上

搬运一个知乎的帖子(侵删),非常专业,作者 到处挖坑蒋玉成 应该是搜索从业人士,可以参考 网页链接

【既然是搜索产品,那就要以搜索产品的标准来进行评判。OpenAI的人在推特上说ChatGPT目前推断一次的成本需要几美分,延时基本上以秒为单位。而通用搜索引擎(即所谓的“大搜”)的召回和粗排的在线计算成本几乎可以忽略,精排部分也比较轻量(注意跟电商和推荐的精排不一样),计算代价的大头主要来自于相关性模型(通常基于BERT/ERNIE等),主流的搜索引擎都要求网络条件良好的情况下不能产生用户可以明显感知的端到端推断延时。

据我了解,百度目前使用的是24层ERNIE,经过推断优化之后(百度有自己的飞浆框架)部署在单卡V100上,而Google应该是使用差不多或更大规格的BERT部署在自家TPU上。一般搜索引擎的相关性计算发生在粗排之后。我们假设取粗排结果的top50进行计算,每一个结果要求延时控制在20ms之内,那么一次query对应的GPU/TPU计算时间就是50X20=1000ms,正好是1s。

为了便于计算成本,这里我们直接以V100为例,阿里云上的一台V100实例的价格是每小时26.46元人民币,按秒计算的话就是每秒价格0.00735元人民币,不到一分钱。如果ChatGPT一次推断是3美分的话,按汇率6.8计算,那么ChatGPT一次推断的成本就是搜索引擎一次query的0.03*6.8/0.00735=27.75倍。

这个计算公式已经极大地有利于ChatGPT了——第一,企业自己采购的GPU,使用成本显然远远低于阿里云按小时计费;第二,如果愿意适当让步的话,那么BERT这个级别的模型的推断优化技术已经非常成熟了,不管是剪枝,量化还是蒸馏,都可以极大地降低计算负载,比如搜狗的做法是将模型蒸馏到4层TinyBERT,这样只要一块T4就可以支撑线上推断——而T4实例的价格最低可以压到每小时11元。综合下来,保守估计,搜索引擎一次query的在线计算成本可以压到ChatGPT的1%。

那么问题来了,站在用户的角度,ChatGPT每次推理,给你带来的收益,平均下来能达到搜索引擎的100倍么?站在企业的角度,ChatGPT的每次推理,能带来100倍于搜索query的收入么?这还仅仅是线上计算成本和收益的问题,以商业产品的视角来看,ChatGPT要作为产品进行大规模商用,要解决的远远不止成本这一个:并发访问量、推断延时、答案正确性保证、内容安全……每一个问题都必须解决,每一个问题也都非常棘手,这些问题连学术界都没有摸到门路,更别提工业界了。如果一个产品需要付费使用,高峰期访问得排队,返回的答案还需要再去搜索一遍以确保它没有一本正经地胡说八道,那这个产品显然是没有多大的市场的。

综上所述,ChatGPT,或者说类似的LLM,要实现有效的商业化应用,依然任重而道远。以AI技术的视角来看,ChatGPT确实是非常伟大的奇迹,但至少目前看来,它离“下一次革命”不说完全不沾边吧,至少也是有非常遥远的距离……

顺带一提,LLM并不是今年突然冒出来的东西——GPT-3在2020年就已经诞生了。从这个时间点来算的话,过去两年内,对于LLM训练和推断代价过高的问题,整个工业界都在原地踏步……】

中文内容就4%的数据量,偏门一点的,比如历史问题当然数据反馈有问题,等等量上来自然就好了。

是训练语料库数据在说话,机器哪里懂政治。