Moore提出,半导体芯片上可集成的元器件的数目每12个月便会增加一倍。也就是说,同样规格的芯片的成本,每12个月便会降低一半。几年以后,Moore将定律中的翻倍时间修改为24个月。就这样,在之后30年时间里,简单的几何比例缩小(使芯片上所有元器件越来越小)就保证了稳速的收缩,验证了Moore的预测。Moore定律并非基于科学或工程原理,而是在实践中(其本人为英特尔联合创始人)的总结,而这个总结又反身于行业发展的目标。两年翻倍在很多人眼里没有概念,但如果持续30年,这种力量是惊人的,简单的说,现在我们每个人的手机的计算能力,都相当于30年前举全国之力制造的超级计算机的若干倍。在我的脑海里始终有一个图画:即,信息社会里的种种,经济、生活、社会、人类进步…宏伟得和珠峰一样,而它的底座,竟是那个小到极点的,像针一样的Moore定律地基。

不幸的是,Moore定律正在走向疲惫。因为制程到几个纳米的时候,触及到的正是宏观世界与量子世界的分水岭。

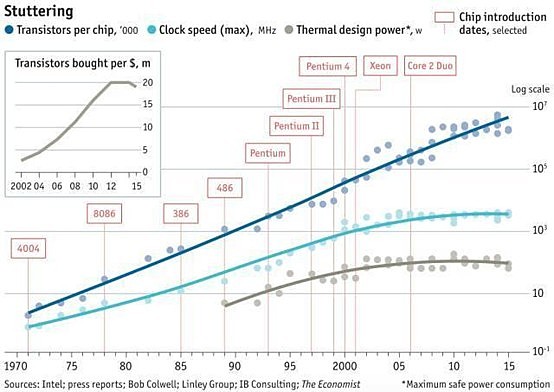

首先,晶体管的尺寸将仅有单个分子大小,晶体管也将变得非常不稳定,尽管可能会有材料上的突破来解决部分问题(应变硅、电容新材料、三栅极晶体);其次,光刻技术已经多内未有系统性突破,我们利用193nm波这把“牛刀”,去做超级精细的14nm“手术”,于是就在中间需要绞尽脑汁想尽各种办法提高精度;再次,CPU的芯片功耗将越来越大,热量在不断增大,散热成了永恒的问题。进入21世纪之后,这样的性能提升逐渐变得困难。受发热因素影响,时钟频率无法继续提高,而单核心的性能只能实现算术式增长。

就CPU论CPU,人类正在想着各种办法:1)寻找一种新的材料——锑化铟和、砷化镓、石墨烯,他们发热量更小,速度更快;2)开发一种新的架构——更多的层级,好像大楼替代现在的平房一样;3)演变一种新的算法——AlphaGo给了我们启发,利用神经网络算法,通过池化卷积的运算过程,可以大幅减少不必要的运算量,但以上三种方案都是短时间难以成熟的。还有几个比较现成的方案:4)更多的核心,16核、32核、64核、72核…5)发展特定芯片做特定命题,如GPU在图形识别效率上明显强过CPU。

图:06年开始,CPU功耗遭遇瓶颈;时钟速度也不再提高,唯有晶体管数量还在增加

2007年英特尔提出的“Tick-Tock”(嘀嗒)战略,Tick年更新CPU芯片制程(缩小芯片面积、减小能耗和发热量);Tock年更新CPU架构,提升性能。Tick-tock,两年一个周期,每个周期CPU速度翻倍,周而复始。但从14nm制程工艺后,tick-tock就开始放鸽子了,英特尔认为自己的两年变成了两年半,也有人认为实则三年,于是,嘀嗒变成了嘀嗒嘀,我们不知道的是,未来是否还将会嘀嗒嘀嗒……

没有什么能够阻挡人类社会的聪明才智,去寻找更完美、有效的解决方案。思路是,站在一个更加宏观的数字世界中寻找答案。

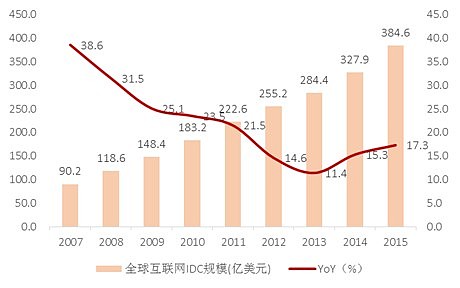

首当其冲是云计算。这个想法很单纯,如果一台计算机解决不了的问题,就用100台去解决。于是,一个基于云的军备竞赛就在各家互联网巨头展开了。目前,亚马逊、谷歌的服务器已经到几百万台量级,微软、facebook、腾讯、百度、阿里巴巴等一批互联网公司都在大手笔的砸入新的数据中心。海量的云计算能力可以帮助企业把大量的内容存储在远程,或者是当算力要求出现rush need的时候,集中调用云资源(算力、带宽、存储的集合)。IDC(互联网数据中心)是脱机软件与云的一个过渡,它与云的区别是,IDC是商业地产,提供的是一种物理环境服务(土地、电、温度、维护等),服务器资产属于用户而不属于IDC端。云,如AWS或者阿里云,则是酒店公寓,拎包入住,按时按量收费。云又分公有云、私有云和混合云,公有云有着更加普适的平台特征,从经济视角来看,公有云的池化效率更高,私有云往往强调安全性和行业特征,是公有云的补充,混合云介于两者之间。公有云又可以进一步细分成SAAS(软件即服务)、IAAS(基础设施即服务)、PAAS(平台即服务)、以及BPAAS(流程即服务)、云广告,IT管理即服务等,细节以后再说。

让我们回想一下,也许是偶然,或者是必然,当2006年CPU时钟频率不再提升的时候,亚马逊的EC2(一般认为是云计算的商业鼻祖)推出了。

其次是智能物联网。物联网大家都不陌生,这里提的是物联网中具有运算能力的那部分,比如打印机可以感知墨盒余量并把它在适当的时间(如墨盒用尽的前一周)传递给适当的人(如经销商),这里除了需要有传感器,还要有处理芯片以及通信模块,处理芯片的作用是智能化的判断场景并作出行动。IPV6之后,地球上的每一粒沙子都可以分给一个独立IP地址,芯片的小型化、场景化、专业化、智能化趋势会越来越明显。想象一下,如果我们可以把这种芯片做到和沙子差不多大小,遍布在地球的每一个角落,它们每个都是独立的个体,智能地根据场景做出判断和行动,于是,不必要像今天这样,所有的功能都要在计算机、手机或者是云端计算,而是极大程度上分布、分散了计算能力,同时,它们将给予我们今天想象不到的丰富的数据,比如比细胞还小的芯片直接从我们血液里输出各种生理数据,个性化的指引我们的用药量、手术辅助等。Smart dust(智能微尘),以自组织方式构成的无线网络,是一种不需要基础设施的自创造、自组织和自管理的网络。它们能够相互定位、收集数据并向观察者传递信息,如果一个微尘功能失常,其他微尘会对其进行修复,并不会影响观察数据的获取。在未来的5-10年,微尘可能会比1mm更小,同时,功耗底使得很小的电池也可以维持工作很多年。

区块链的智能合约也具有颇为相似的思想,即每一个节点与其他节点间的可以通过编程去交互,如,某个孙辈到了十八孙或者祖父死亡的某天执行继承财产,这个交易事件可以写入到区块链中,第一个条件是孙辈到了十八岁,第二个条件是祖父出现在了死亡数据库名单,同时满足两个条件则自动发送资金。区块链源于比特币,技术核心是分布式及密码学,因此区块链更多的应用在银行、证券、保险、交易、契约等领域,尽管,它也可以应用到物联网领域中,至少智能合约的思想与smart dust有不少相似之处——去中心、自组织、智能化。

最后,算法以及架构的提升也是颇为重要的。Hadoop架构源于雅虎,之后变成了全球的开源架构,并且不断演进,它处理海量数据的效率更高,资源消耗更低,且能够实时化的得到结果。中国历史上肥水之战、官渡之战、赤壁之战,都是典型的以少胜多的案例,计谋、士气、组织…这些的集合,造成了几万胜过几十万的效果。于是,如何寻找在大数据时代的这样的结合,做到以少胜多,是大数据架构设计者的历史使命。Hadoop通过不断的演绎也在寻求着自我进化,Cloudera,Hortonworks(Nasdaq:HDP),MapR都是在这个领域里的佼佼者,其中Cloudera实力最强,目标是成为大数据时代的Oracle或者微软。算法优化比较典型的是类人的神经网络算法,这里不再赘述。

因此,在Moore定律失效的前夜,云计算是最笨的解决方案(堆量),但也是最直接的、有效的方案。这样看尽管未免有些狭隘,下一章会提到云计算的未来属性,但这种观点没什么大问题。

如果把计算机当成一个原点,未来的世界正在走向两端:一端向上,通过规模集中(云计算)、架构重整(hadoop升级)、算法优化(神经网络)去提升效率;一端向下,通过规模分布式(物联网),小型化(smart dust)、专业化(无人驾驶、无人机、智能电网、机器视觉等)、智能感知交互(区块链、VR、语音搜索、图像识别等)去改变世界。这些方向,都将成为接下来5-7年TMT投资的重点投资领域。

本文作者:王学恒,如转载请注明出处。