芝能智芯出品

芝能智芯出品

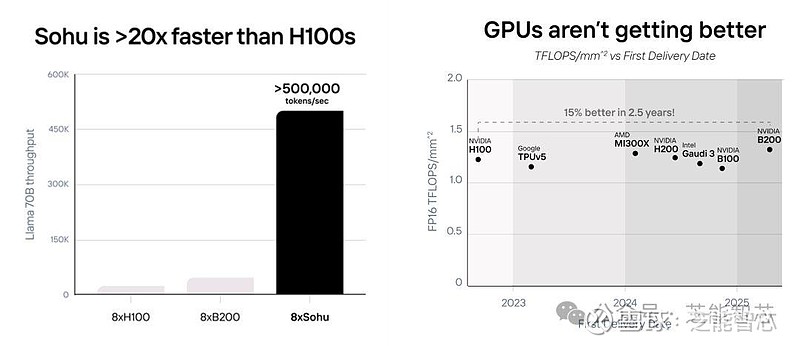

初创公司 Etched 宣布推出其最新的 AI 加速器芯片“Sohu”,这是一款专用集成电路(ASIC),据称在大型语言模型(LLM)的推理性能上比 Nvidia 的 H100 GPU 快 20 倍,有望降低数据中心的初始和运营成本。

Part 1性能对比:Nvidia H100 vs. Sohu

Etched 声称,其 Sohu ASIC 可以在 AI LLM 推理方面超越 Nvidia 的 H100 GPU。一台 8xSohu 服务器的性能相当于 160 个 H100 GPU。这种性能提升源于搜狐专门为 Transformer 模型优化的设计,意味着在处理特定 AI 工作负载时能够提供更高的效率和速度。

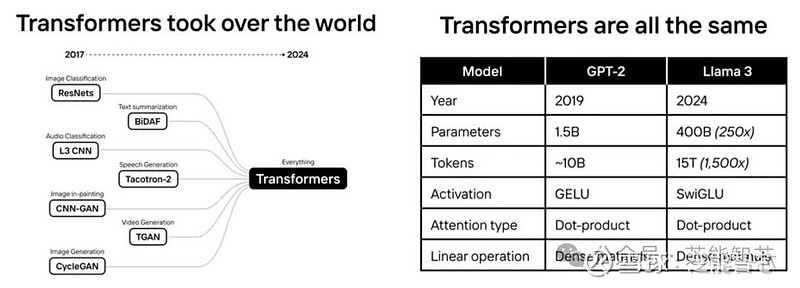

英伟达的 H100 是目前市场上最先进的 GPU 之一,广泛用于各种 AI 应用,这些通用 AI 芯片必须支持多种 AI 架构,如卷积神经网络(CNN)、长短期记忆网络(LSTM)和状态空间模型(SSM)。为了满足不同的计算需求,H100 的设计中包含大量可编程功能,而这些功能在运行 Transformer 模型时并非都被充分利用。

Etched 的首席执行官表示,Nvidia H100 的硅利用率中,只有 3.3% 的晶体管用于 Transformer 模型的关键任务(主要是矩阵乘法),其余的 96.7% 则用于支持其他任务。Sohu芯片则通过硬件专门优化了 Transformer 模型的执行效率,能够更有效地使用晶体管。

Part 2Etched 的技术赌注

在 2022 年启动Sohu项目时,Etched 预见到了 Transformer 架构在未来 AI 应用中的潜力。Transformer 模型已经成为当今大型语言模型(LLM)的基础,包括 ChatGPT、Sora、Gemini、Stable Diffusion 和 DALL-E 等知名模型。

模型的大部分计算任务涉及大量的矩阵乘法,这是 Transformer 架构的核心。Etched 通过在硬件层面优化这种计算任务,使搜狐能够更高效地处理 Transformer 模型。与当前 AI 芯片类似于多功能 CPU 不同,搜狐更像是一个专用的 GPU,专注于一个特定领域的计算任务。

英伟达目前在 AI 硬件市场占据主导地位,特别是在数据中心领域,H100 GPU 是高性能 AI 推理的标杆。在 2023 年售出了 376 万台数据中心 GPU,并且这一趋势在 2024 年继续增长。

Etched 的专用 Transformer 芯片如果能提供更高的性能和更低的成本,可能会吸引那些主要使用 Transformer 模型的公司。如果 AI 数据中心和企业能够使用 Sohu 芯片来提高性能,同时降低成本,这将对 Nvidia 的主导地位产生重大影响。

小结

Sohu 的推出是AI 加速器市场上的一次创新突破。如果该芯片能达到预期性能---在特定 AI 应用中比 Nvidia H100更高效,可能会为 AI 硬件市场带来新的竞争格局,并为数据中心节省大量的初始和运营成本。