财联社5月12日讯(编辑 牛占林)英国人工智能(AI)安全研究所本周五发布了发布了一个新的测试平台,旨在加强监测先进AI模型的安全风险。

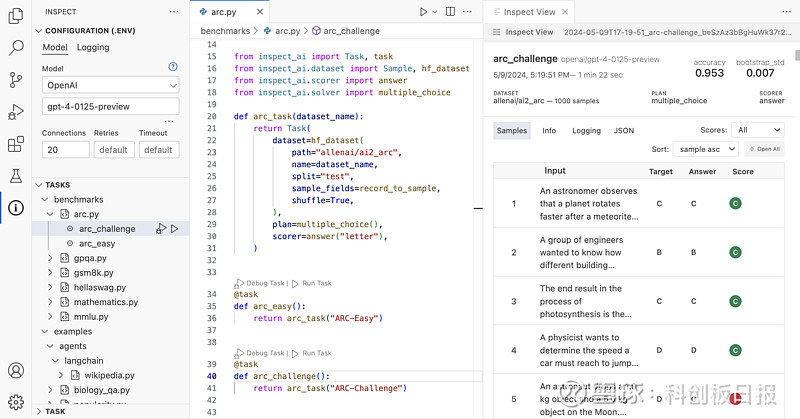

据介绍,该工具箱名为Inspect,可以用来评估一系列领域的AI模型,包括它们的核心知识、推理能力和自主能力。通过开源许可证发布,这意味着Inspect可以免费供全球AI社区使用。

英国去年10月份宣布成立人工智能安全研究所,将研究和测试新型AI模型;今年2月,英国还表示将斥资1亿多英镑启动9个新的研究中心,并对AI监管机构进行技术培训。

在新闻发布会上,英国人工智能安全研究所表示,Inspect是一个软件库,它使测试人员能够评估单个AI模型的具体能力,然后根据结果给出一个分数。

Inspect从周五开始可以使用,这也是由国家支持的机构率先推出的AI安全测试平台。

在当前AI竞赛热潮下,越来越多的AI模型将会在今年上市,这使得推动AI安全发展比以往任何时候都更加紧迫。

但目前要对AI模型进行基准测试还是比较困难的事情,因为当今最复杂的AI模型基本上都是“黑箱”,其基础架构、训练数据和其他关键细节通常被创造它们的公司保密,不对外公开。

那么,Inspect是如何应对这一挑战的呢?主要是通过其可扩展性,能够适应并接纳新的测试技术。Inspect内置组件可以通过使用Python编写的第三方软件包来增强或扩展。

Inspect由三个基本部分组成:数据集、求解器和计分器。数据集用于评估测试的样本集合,求解器是执行实际测试工作的组件,评分器的作用是评估求解器的工作成果,最终生成关于AI模型性能的综合评价,这种设计使得Inspect能够灵活地适应不同的测试需求和评估标准。

英国科学部长米歇尔·多内兰表示,作为英国在AI安全领域持续领导的一部分,我批准了开源的Inspect,这显示了英国在创新和科技发展方面的独特才能和创造力,并巩固了我们作为该领域世界领导者的地位。

人工智能安全研究所主席Ian Hogarth声称,成功的AI安全测试合作意味着拥有一个共享的、可访问的评估方法,我们希望Inspect能成为AI安全研究所、研究组织和学术界的基石。