2024 年,由 AI 驱动的 GPT-4o 等应用产品爆红。这些热门产品的广阔应用前景令人振奋,吸引了大量资源投入 AI 的算法研究、数据清洗、算力等方面的基础建设中。

这些爆款应用是由大数据训练的大模型支撑的。

举例来说,近年来,大语言模型的训练数据和模型的体量迅速增长,从 2017 年发布的有 1.65 亿参数量的 Transformer,到 2020 年发布的有 1750 亿参数量的 GPT-3,再到 2022 年发布的 ChatGPT 应用背后的模型也至少有数百亿参数量。

这样的训练数据和模型体量的增长带来了模型能力的提升,让大模型“涌现”出指令跟随、上下文学习等能力,展示出“通用”的生成能力。

有目共睹的是,生成式任务的智能算法模型扩大,对算力的需求急剧增加。

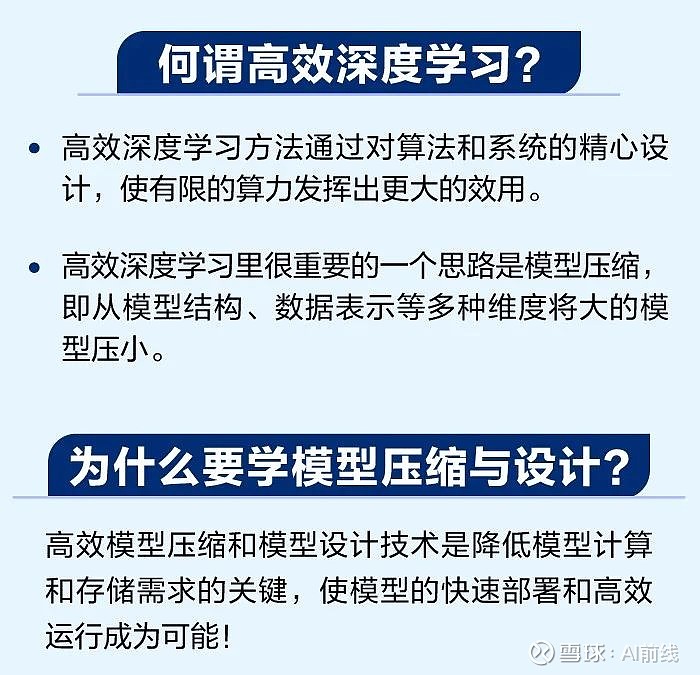

在这个背景下,高效深度学习领域显得尤为关键,得到了广泛关注。

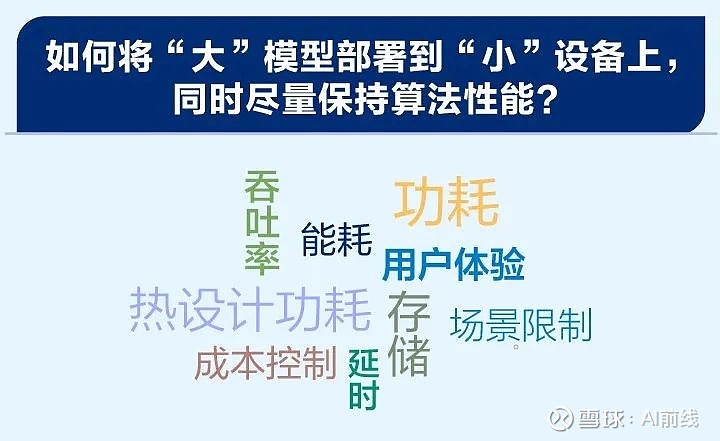

如何将“大”模型(参数量大、计算量大)部署到“小”设备上(资源受限,计算和存储能 力低),同时尽量保持算法性能是各应用领域都非常关心的话题。

实际应用场景关心的硬件性能指标主要包括延时(Latency)、吞吐率(Throughput)、功率(Power)、能耗(Energy)和存储(Storage)。

对这些指标的要求反映出用户体验、场景限制、成本控制多方面的需求。例如:

延时和吞吐率影响了可用性和实时性;

热设计功耗(ThermalDesign Power,TDP,即最大负荷的能量释放)决定硬件冷却系统所需具备的散热能力水平;

能耗和存储均直接影响系统成本,等等。

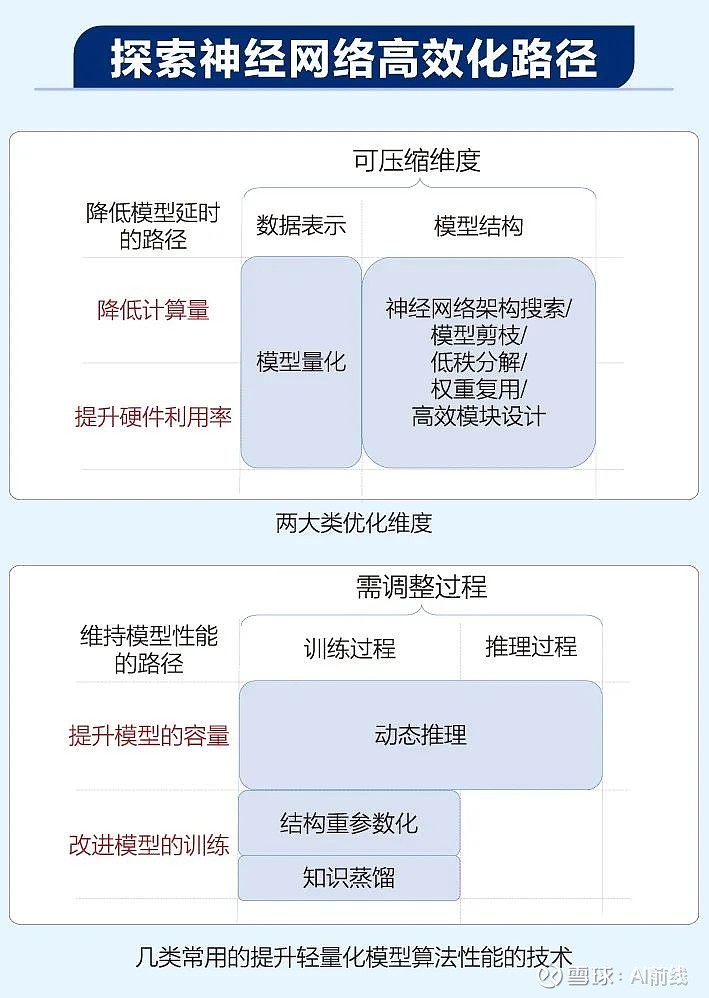

为优化这些指标,研究者和工程师探索了多条路径,纵跨不同设计层次,包括算法设计、软件设计、硬件设计。

在硬件层次,根据算法特性定制化地设计硬件架构,其中可能涉及采用新型器件,代表性工作包括基于 FPGA 和 ASIC 的专用硬件架构设计、基于存算器件的专用硬件架构设计。

具体来说,这些工作根据神经网络的算法特性(例如,算子类型、数据的复用模式等)或新器件特性(例如,模拟域计算或存储的能力、器件的非理想特性等)设计专门的计算单元、数据流、指令等,从而用更低的能耗完成同样的计算,即达到更高能效(Energy Efficiency)。

在软件层次,开发者需要针对神经网络模型和硬件平台的特性实现计算算子或系统软件,并开发编译优化工具等,例如,编译优化工具可将神经网络计算流图进行优化、切分、映射,从而将其部署到硬件平台,典型工作包括机器学习编译框架 TVM 等。

在算法层次,轻量化算法设计针对软硬件系统特性调整算法,通过调整神经网络的模型结构、数据表示等降低其计算开销(Computation Cost)、访存开销(Memory Access Cost)和存储开销(Memory Overhead)。计算开销、访存开销和存储开销的降低最终会体现在延时、吞吐率、功率、能耗、存储容量等指标上。

《高效深度学习:模型压缩与设计(全彩)》一书主体部分围绕“轻量化算法设计”这一思路展开,即通过从头设计或通过压缩已有模型得到更高效的轻量化模型。

书中详细介绍了模型压缩的方法论,包括高效模块设计、模型剪枝、模型量化、模型二值化、神经网络架构搜索、知识蒸馏几大部分。

另外,本书简要介绍了定制化硬件加速器的设计及大语言模型的加速和压缩。

适读人群

对于希望进入模型压缩领域的初学者,本书归纳了高效深度学习领域的整体框架,并注重阐述和辨析重要的基本概念,希望可以帮助读者快速获得对该领域的整体认知和掌握重要概念。

对于有一定科研经验、希望在相关科研方向进行探索的读者,本书在多个层次提供了框架性总结,定位多个子领域之间、同一子领域内多个方法之间的关系,希望可以帮助读者加强对知识的整合,利用框架更好地进行创新探索。

对于需要工具书辅助解决实际问题的读者,本书不仅包含对实践经验的总结,也包含对每个细分技术及其应用的逻辑的详细说明,希望可以帮助读者厘清分析和解决问题的思路,并快速定位到相关文献。

名家点评

本书系统地解析了压缩、设计与量化神经网络模型的技术,严谨地梳理了重要概念、逻辑与框架,理论结合实践,深入浅出。

谢源 香港科技大学讲席教授阿里巴巴达摩院荣誉顾问(ACM Fellow,IEEE Fellow,AAAS Fellow):对初学者而言,本书是快速掌握该领域的理想教材;对研究者与从业者而言,本书是深化理解、拓宽视野、启发创新的宝贵资源。无论求知或深耕,皆可借本书汲取知识、收获启迪,共探人工智能前沿。

陈怡然 杜克大学电气与计算机工程系教授(AAAS Fellow,ACM Fellow,IEEE Fellow,NAI Fellow):本书全面梳理了高效模型压缩和模型设计的方法论,结构逻辑清晰,内容紧跟前沿。书中提供的系统性的方法论总结和前沿性的知识介绍能为该领域的科研工作者提供许多启示。

王云鹤 华为算法应用部部长:本书全面地总结了模型压缩方法论,同时分享了不少实践经验,这对模型压缩方法在工业界的实际应用提供了重要参考,是值得学习的优秀教材。

活动推荐

为答谢读者朋友们的支持,「AI 前线」为大家准备了 3 本《高效深度学习:模型压缩与设计(全彩)》纸质书籍。关注「AI 前线」公众号,回复「深度学习」参与抽奖,开奖时间:7 月 17 日 18:00。

内容推荐

AIGC技术正以惊人的速度重塑着创新的边界,InfoQ 首期《大模型领航者AIGC实践案例集锦》电子书,深度对话30位国内顶尖大模型专家,洞悉大模型技术前沿与未来趋势,精选10余个行业一线实践案例,全面展示大模型在多个垂直行业的应用成果,同时,揭秘全球热门大模型效果,为创业者、开发者提供决策支持和选型参考。关注「AI前线」,回复「领航者」免费获取电子书。

今日荐文

Karpathy又整活儿了!一天训练出GPT-2、成本还骤降100倍,网友:dream老黄把价格再打下来

有赞取消 HRBP 岗位,员工拍手叫好!中国科技大厂的尴尬境地:既要富士康的效率,又要谷歌的创新

微软中国CTO韦青:亲身经历大模型落地的体会与思考

零就业保障、全天精神“酷刑”!ChatGPT类产品背后80%贡献者,时薪1.16美元,但也没得选

网易员工内部群怼丁磊:人人陪你演戏点赞;李彦宏:开源模型是智商税;小红书再裁员:人效比只能达到拼多多的一半 | AI周报

你也「在看」吗?