为了方便构造数据写了代码去截图,只需要收集足够数据,训练,相信单轮指令控制应该可以有初步效果了:你只需要文本或语音给出指令,可以让AI控制鼠标或键盘执行某个动作。如帮助老人不会用智能、电脑手机的问题。但更长远的规划也是更大的意义在于人机交互方式的变革。

从以前的命令行到如今的图形界面操作,再到未来的对话交互完成任务,未来AI"读心术"能力提高到商业水平甚至可以转变为,从脑电波(想法)直接到任务的完成。

这个场景,平面控制动作相对容易,现实世界,除了深度视觉和身体的平衡需要考虑。如果让大语言模型驱动机器人的身体,需要更多的依赖对当前状态的评估,因为现实世界很少一两个动作能达到目标,长动作流几乎是必然现象。平衡的的方案是小模型负责执行具体动作和评估目前状态,大模型负责决策,主要是为了动作执行部分为了快速实时。

从这个层面开始,才能看到,AI真正全方面走进人类个体的世界了。

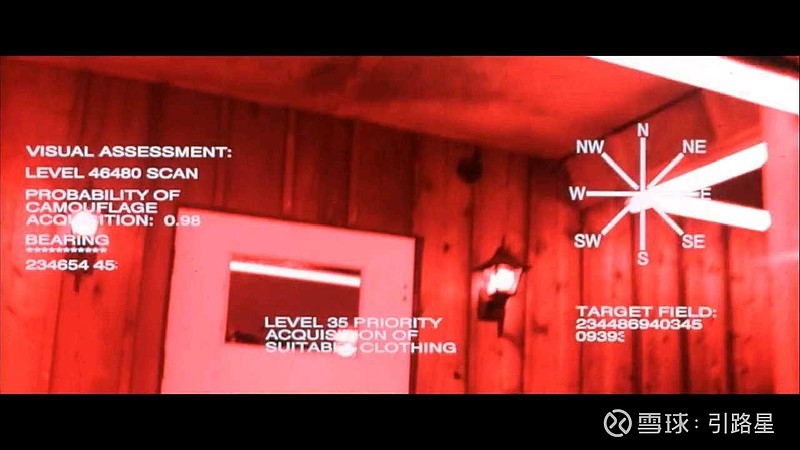

这个从终结者电影中就可以看到AI视角下它是如何决策的。

比如除了找到车辆外,排level35的优先级是找到合适衣服:aquisition of suitable clothing,在完成这个任务中通过视觉顺便还确认了待使用、合适的交通工具,根据酒吧处于营业中,计算出找到合身衣物的概率很高(推测有很多成人男性),高于0.9,作出 camouflage cover within the structure 的判断,从而决定走进酒吧,并在打开酒吧门之前开启defense mode,之后的就是计算每个人的体格参数看哪一个匹配,靠近人的危险评估,target距离之类的。

从中,我们能看到的是AI一系列自主的的实时流式计算和决策,这是目前大需语言模型可以做但现在没有去做的事。而这才是下一代AI要去做的事,当尝试让AI控制鼠标键盘操作界面时,对于复杂的任务,已经开始涉及到这种动作流的评估和决策了。