当机器代替一切时,我们作为人类的身份又如何体现?

最近的一段娱乐纠纷,让人开始担忧电话诈骗将会“更上一层楼”:当骗子也开始使用人工智能,我们该怎么办。

事件的发酵始于OpenAI公司发布的新款语音聊天机器人GPT-4o。据雅虎新闻网21日报道,这款机器人内置有5种声音模式,其中一个名为“天空”的模式与“寡姐”斯嘉丽·约翰逊的声音非常相似。OpenAI首席执行官奥特曼曾邀请“寡姐”为该系统配音,但她以个人原因拒绝。“寡姐”对发布会的展示“感到震惊、愤怒,难以置信”,称其声音根本难辨真伪。

显然,这是人工智能科技发展史上的又一次“噪音”,它显示出对于高科技企业规范和监管的根本问题在于,法规和政策的推进速度远不及创新的速度。世界将因人工智能和算法而改变,其中有一些变化可能是有益的,另外一些几乎肯定会是灾难性的。如何权衡其中的利和弊?

而当以后的人们为人工智能(AI)撰写一部编年史时,这可能是一个里程碑。

AI创新带来的噪音

人们已清晰认识到:我们离不开AI,亦需要大力推动AI技术发展,但我们必须有能力防范其中的风险。

“寡姐”事件之前,美国就出现了“AI拜登”事件,由AI生成的“假拜登”在电话中用逼真的声音鼓励可能支持民主党的5000位选民在新罕布什尔州初选中不要投票。

一切要归咎于人工智能初创公司OpenAI发布的一项人工智能语音引擎(Voice Engine)。这一系统可以从15秒的音频样本中生成与原始说话者声音高度相似的自然语言语音。也就是说,如果你上传一段自己的录音和一段文字,这款语音引擎就可以使用听起来和你声音一样的合成声音,来阅读文字。此外,语音引擎“复制”出来的声音不一定只能朗读原始说话者的母语文字,它还能用西班牙语、法语、汉语等多种语言“重现”原始说话者的声音。

这个创新同样是革命性的。它能通过为个体提供个性化的、非机械化的声音,为那些有语言障碍或学习需求的人提供治疗和教育方面的帮助,同时也能增强有学习需求人群的教育体验。

但问题也接踵而至。生成式AI聊天工具背后的大语言模型通常是使用从互联网上搜刮的文本、图像、音乐和视频训练的,其中可能包括受版权保护的、宝贵的、通常是付费的材料,比如“寡姐”的声音。同时,语音生成器和图像、视频生成器一样,可能在社交媒体上传播虚假信息,也可能被不法分子利用为线上或电话诈骗的工具。OpenAI称,他们非常担心这种技术还可能被错用来破解在线银行账户和其他个人应用程序的语音认证。

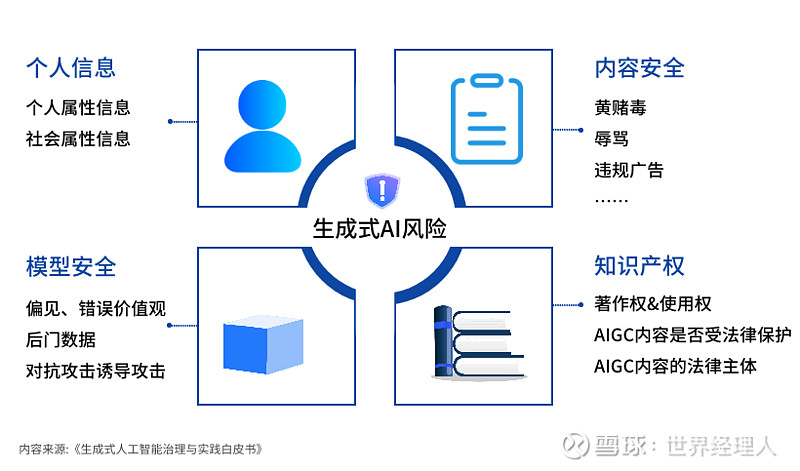

AI安全性再次被提上日程。目前AI创新带来的“噪音”主要集中于以下三方面:

隐私泄露:许多AI系统能处理人类敏感信息,如果这些系统存在安全漏洞,可能会导致用户隐私泄露、身份盗窃,甚至对整个社会造成威胁。

恶意攻击:恶意攻击者可能会试图利用AI系统中的漏洞来实施各种攻击,包括篡改数据、冒充身份、欺诈行为等。

决策误导:一些AI系统被用于自动决策,如招聘、信用评估和法律判决等。如果这些系统受到恶意攻击或者被有意扭曲,可能会导致不公平、错误的决策,甚至加剧社会不平等。

并非杞人忧天

外界认为,“寡姐”事件中Open AI公司的表现体现了被人诟病的“硅谷方式”:请求原谅,而不是征得同意。这同时表明,硅谷高科技企业曾经强调的产品安全责任逐渐让位于产品表现以及利润。

各方监管机构正在考虑如何通过新法律,将这一现存的“灰色地带”清晰化。据悉,美国多个政府机构正寻求“水印”等内容验证的最佳方法,拟定先进的网络安全计划。专家也建议,各国政府需建立可快速行动的AI监管机构,并为这些机构提供资金。联合国大会也投票通过了首个关于人工智能(AI)的决议草案,以确保这项新技术能够惠及所有国家、尊重人权,并且是“安全、可靠和值得信赖的”技术。这项决议的历史意义在于,它是首次为安全使用人工智能制定了原则。

但问题的根本在于,法规和政策的推进速度远不及创新的速度,而企业的配合意愿也在降低。

虽然有一些人希望科技巨头们制定自我监管规则,以确保AI的发展合乎道德规范,但谁又能抵御技术和利润诱惑的吸引?

许多专家都不愿意AI发展得太快。它造成的威胁听起来可能有点儿像科幻小说中的场景,但它们最终可能被证明是有效的。“寡姐”事件使我们担忧,大规模网络犯罪、社会操纵和其他危害会迅速升级。甚至在公开冲突中,AI系统将能自主部署各种武器,甚至包括生物武器。可以想象,当AI的进步不受控制时,很可能最终导致大规模生命损失、生物圈破坏、人类边缘化甚至灭绝......

当然,要想达到足以威胁人类生存的程度,AI还有很长的路要走。但AI的进步是如此突飞猛进的,以上担忧也并非杞人忧天。

愿我们在人类文明发展的大风大浪中,更早看到灯塔,也能避开险滩。

本文版权归世界经理人所有

(网页链接)