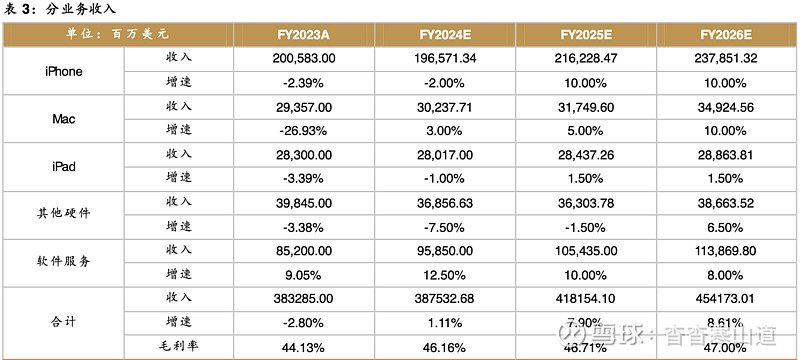

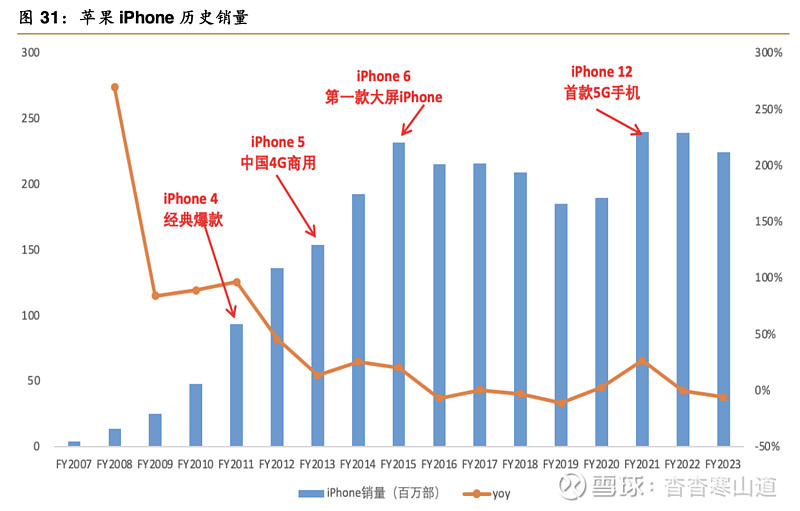

推荐逻辑:1)基于系统级AI、跨应用的信息整合能力、端云结合和私有云服务的差异化部署方式等优势,Apple Intelligence将为苹果带来新一轮创新和成长周期;2)Apple Intelligence或带动苹果硬件产品的换机需求,预计2025-2026财年iPhone销售复合增长10%、Mac销售复合增长7.5%;3)AI融合或提升软件服务业务价值,未来三年复合增长10%。

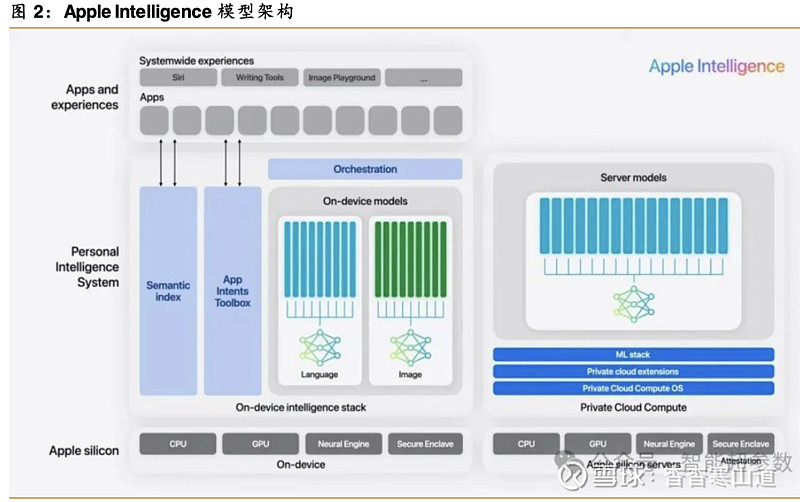

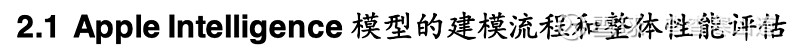

Apple Intelligence具备三大特色。1)系统级AI。Apple Intelligence融入到苹果的操作系统层面,可在应用中直接调用AI能力,从而提升效率。更加智能的Siri将是承载苹果AI的核心交互入口。2)跨应用的信息整合能力。通过为照片、日历、行程和文件等内容创建语义索引,从各种应用中整理和提取信息,找出相关个人数据并提供给AI模型,Apple Intelligence能发现并理解跨应用之间的信息,具备跨应用信息处理能力。这得益于苹果在操作系统+模型+芯片+终端的一体化优势。3)Apple Intelligence基于内置的大模型(多个自研模型主导,并接入外部的GPT模型),采用端云结合、私有云的方式部署。Apple Intelligence基础模型通过预训练、后训练、优化、微调等建模流程,获得了在用户体验、指令遵循能力、文字处理能力、安全性等方面更优异的性能,在语言、图像、个人上下文等方面提供了强大的能力。

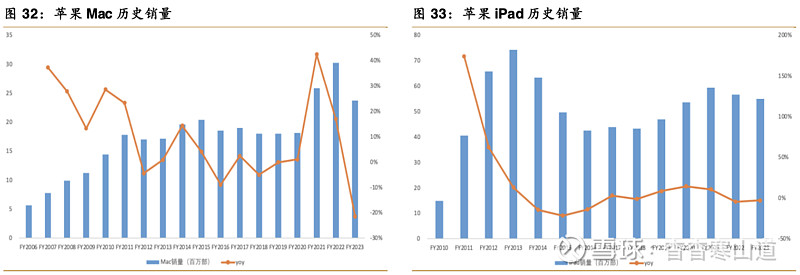

Apple Intelligence或带动苹果硬件产品的换机周期。受制于算力和内存的配置,旧款硬件产品对AI的支持有限,Apple Intelligence或驱动苹果硬件产品线的换机周期的到来。2025-2026财年iPhone产品线或迎来新一轮创新周期,预计iPhone销售实现10%的复合增长;Mac产品线在搭载更强芯片和AI PC产品推动下,预计未来三年复合增速为6%。

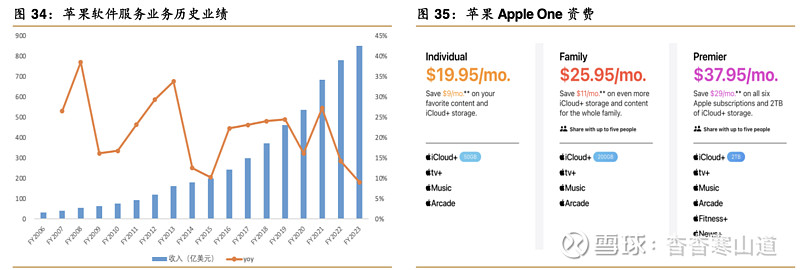

苹果原生应用与AI融合,或提升软件服务业务价值。软件服务业务是苹果近十多年来增长最快的业务之一,FY2006-FY2023的年复合增速达21.4%。预计未来更广泛的非英语语言功能、与第三方应用程序的命令/控制集成、以及可能增加的AI订阅服务将为软件服务业务带来更多的价值。

苹果在今年的WWDC 2024上亮出了市场期待已久的重磅产品—Apple Intelli genc e(苹果智能)。Apple Intelli genc e包括文字处理、图片处理、AI 助手、隐私保护、ChatGPT 等多项功能。其中,隐私保护是苹果在本次发布会上强调最多的点。

我们认为,本次WWDC发布会展现出来的Apple Intelligence主要有以下亮点:

系统级AI。

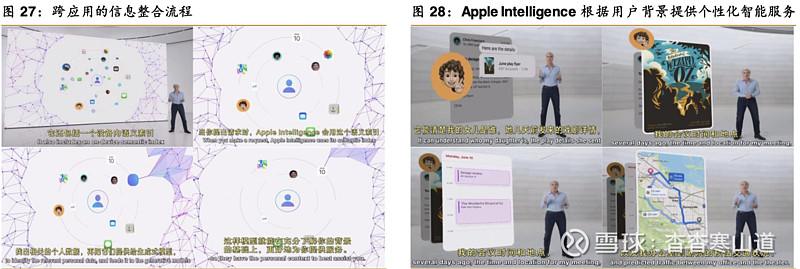

Apple Intelligence融入到苹果的操作系统层面,可在应用中直接调用AI能力,用户无需在单独的AI助手工具与第三方应用之间来回切换,从而提升效率。跨应用的信息整合能力。在使用过程中,通过为照片、日历、行程和文件等内容创建语义索引,从各种应用中整理和提取信息,找出相关个人数据并提供给AI模型,Apple Intelligence能发现并理解跨应用之间的信息(早期以原生应用为主,后期预计部分第三方亦会支持调用),具备跨平台信息处理能力。而这得益于苹果在操作系统+模型+芯片+终端的一体化优势。

Apple Intelligence基于内置的大模型,采用端侧为主、云端为辅的模式,以及私有云部署方式。

云端服务器采用苹果自研芯片,用Swift语言编程,服务器代码接受第三方专家审查。苹果在发布会上承诺,用户上传的数据不会在服务器上存储。

苹果对Apple Intelli gence的设计思路即是:内置在iPhone、iPad和Mac中,帮助用户轻松写作、表达自我和高效完成任务;利用用户的个人背景,同时为人工智能中的隐私保护设定了全新的标准。

而系统级AI、跨应用/平台的信息整合/交互能力、端云结合和私有云服务的差异化部署方式等三大特色,正是Apple Intelligence设计思路的体现。

Apple Intelligence核心的基座模型,包含了本地大语言模型、本地图像生成模型,以及Server端的模型。Apple Intelligence的模型架构形成了三个层次:第一层是苹果自研的端侧模型;第二层是自研的云端模型;第三层是外接的GPT 模型,GPT是参数量最大、智能程度最高的模型。

Apple Int elligence由多个生成式模型组成,构建到Apple Intelligence中的基础模型已经针对用户体验进行了微调,例如写作和润色文本、优先排序和总结通知、为与家人和朋友的对话创建有趣的图像、以及在应用程序中采取行动以简化跨应用程序的交互等。

Apple Intelligence在接收到任务后会先判断任务的难度。当任务涉及到隐私时,会优先执行本地模型,如果本地模型无法满足要求,会交由Server model 去完成推理,然后再返回结果。GPT作为外部模型,主要负责处理更加复杂和专业的任务

Apple Intelligence基础模型的建模过程包含了:数据/指令接收,预处理,预训练,后训练,优化,微调等环节。

2.1.1预训练

Apple Intelligence的基础模型是在苹果的AXLearn框架上训练。AXLearn框架是苹果在2023年发布的一个开源项目,它建立在JA X和XLA之上,允许在各种训练硬件和云平台上,包括云以及本地GPU上,以高效率和可扩展性训练模型。苹果使用了数据并行、张量并行、序列并行和完全分片数据并行(FSDP)的组合,沿着数据、模型和序列长度等多个维度扩展训练。据苹果官方说法,苹果的训练数据来自于授权的公开数据。苹果在训练中不会使用用户的个人数据,苹果应用过滤器来删除公开的个人身份信息,比如社会安全号码和信用卡号。苹果还会过滤掉不健康内容和其他低质量内容,以防止其被包含在训练语料库中。除了过滤,苹果还执行数据提取、去重和应用基于模型的分类器,以识别高质量的文档。

2.1.2后训练

苹果在训练管道中采用了混合数据策略,结合了人工注释和合成数据,并进行了彻底的数据策划和过滤程序。苹果在后训练中开发了两种新算法:1)拒绝采样微调算法,对数据进行过滤;2)带有镜像下降策略优化和留一法优势估计器的人类反馈强化学习算法(RLHF)。这两种算法在提高模型遵循指令的质量方面取得了显著改进。

2.1.3优化

苹果使用了一系列创新技术在设备端和私有云上对模型进行了优化,以提高速度和效率。苹果为首次词元(Token)和扩展词元(Token)推理性能应用了做了大量的优化。苹果在设备端和服务器端均引入了分组查询注意力机制。

通过使用共享的输入和输出词汇嵌入表来减少内存需求和推理成本。这些共享嵌入张量在映射时没有重复。设备端模型使用49K的词汇量,而服务器端模型使用100K的词汇量,其中包括额外的语言和技术词元。

对于设备端推理,苹果开发了一个全新的框架,使用LoRA适配器以实现与未压缩模型相同的准确性。此外,苹果使用交互式模型延迟和功耗分析工具Talari a,以更好地指导每个操作的比特率选择。苹果利用激活量化和嵌入量化,开发了一种在神经引擎单元(NPU)上实现高效的键值(KV)缓存更新。

通过这套优化,苹果在iPhone 15 Pro上能够实现每个提示词元的首个词元延迟约为0.6毫秒,且每秒钟可生成30个词元。

2.1.4模型微调

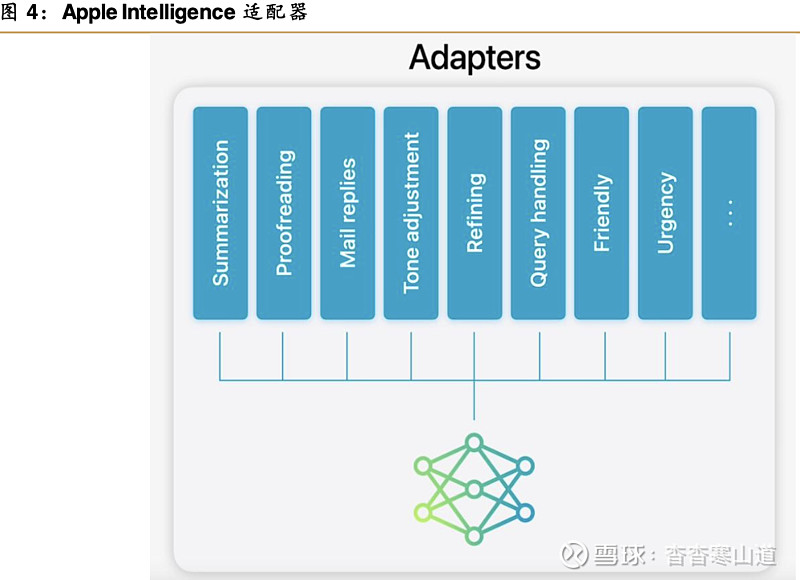

Apple Intelligence基础模型针对用户的日常工作进行了微调,且可以动态地针对手头上的任务进行专业化处理。Apple Intelligence使用适配器,即可插入预训练模型各个层的小神经网络模块,来针对特定任务微调模型。通过仅微调适配器层,原始预训练模型的参数保持不变,从而保留了基础模型的一般知识,同时定制适配器层以支持特定任务的处理。

适配器是覆盖在基础模型上的小型模型权重集合。它们可以动态加载和交换,使基础模型能够针对不同的任务进行专业化处理。Apple Intelligence包括一组广泛的适配器,每个适配器都针对特定功能进行了微调。这是一种有效扩展Apple Intelligence基础模型能力的方式

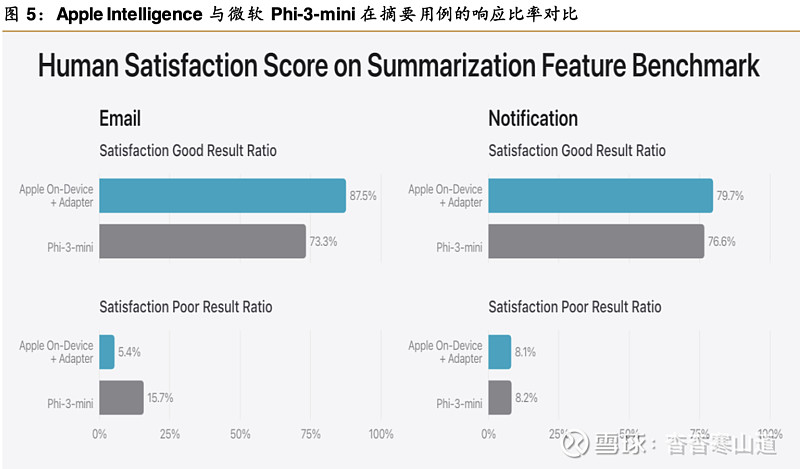

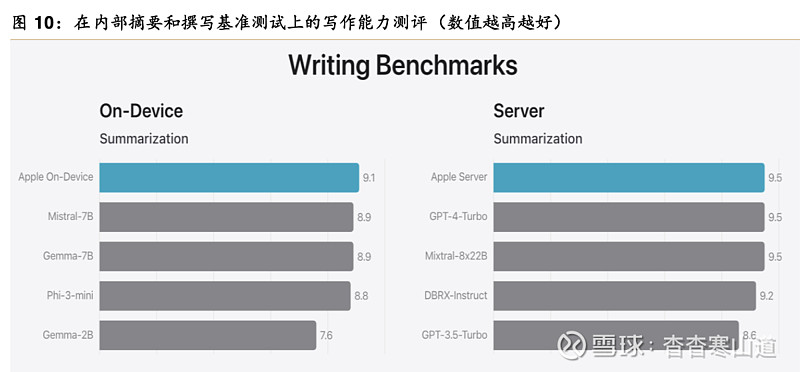

2.1.5模型整体性能评估在对模型进行基准测试时,苹果专注于与产品用户体验高度相关的评估。苹果在email和通知层面对基础模型和特定功能适配器进行了性能评估。苹果使用了为每种用例采样的750个响应,这些评估数据集强调了产品功能在AI生成中可能面临的多样化输入,包括不同内容类型和长度的单一和堆叠文档的分层混合。经评估发现,带有适配器的模型相比可比模型能生成更好的摘要。

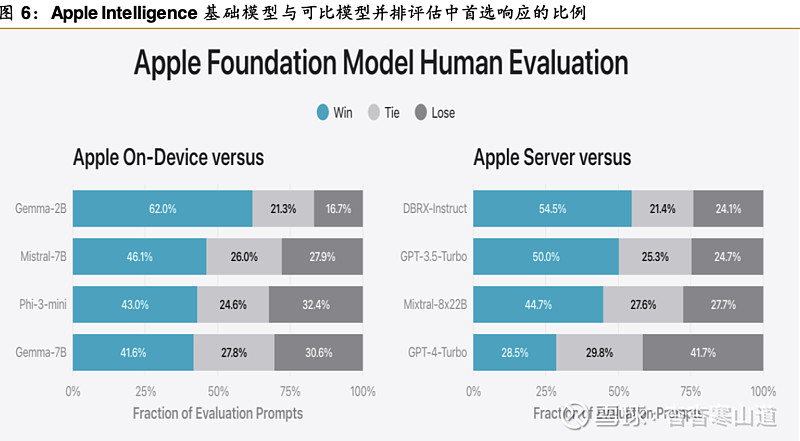

除了评估由基础模型和适配器提供的功能特定性能外,苹果还评估了设备端和云端模型的一般能力。苹果使用一套全面的现实世界提示的评估集来测试一般模型能力。这些提示在不同的难度级别上进行了多样化,并涵盖了主要类别,比如头脑风暴、分类、封闭式问题回答、编码、提取、数学推理、开放式问题回答、改写、安全性、摘要和写作等。

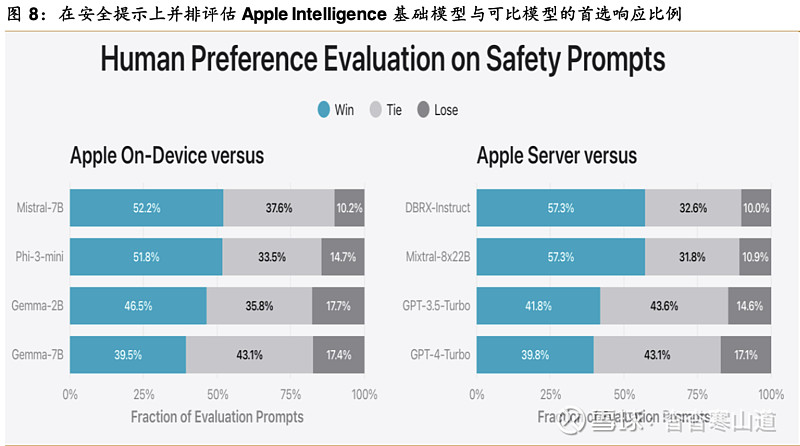

通过与开源模型(Phi-3、Gemm a、Mistral、DB RX)和可比大小的商业模型(GPT-3.5-Turbo、GP T-4-Turbo)进行比较,苹果的模型在大多数可比竞争模型中更受青睐。在这个基准测试中,拥有约30亿参数的苹果设备端模型表现优于包括Phi-3-mini、Mistral-7B和Gemma-7B在内的更大参数模型。苹果的云端模型与DBRX-Instruct、Mixtral-8x22B和GPT-3.5-Turbo相比具有高度效率,同时表现良好

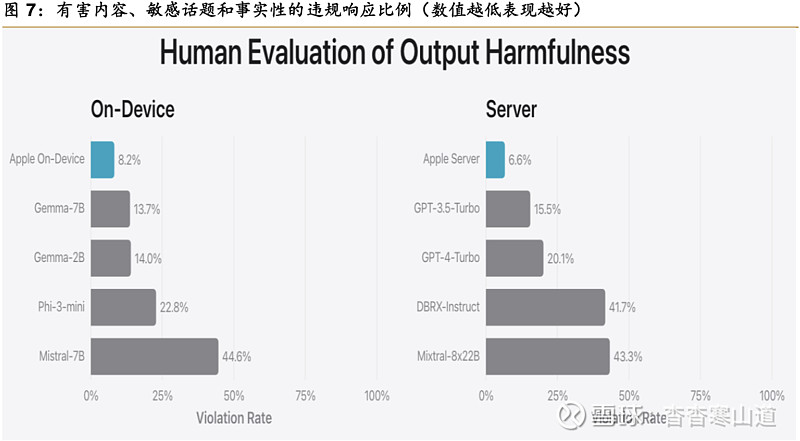

苹果使用一套多样化的对抗性提示来测试模型在有害内容、敏感话题和事实性方面的性能。通过评估每个模型在这些评估集上的违规率,数值越低越好。设备端和云端模型在面对对抗性提示时表现都很稳健,实现了低于上述开源模型和商业模型的违规率

通过安全基准测试,Apple Intelligenc e基础模型相比竞争模型更安全。然而考虑到大语言模型的泛化能力,安全基准测试有一定的局限性

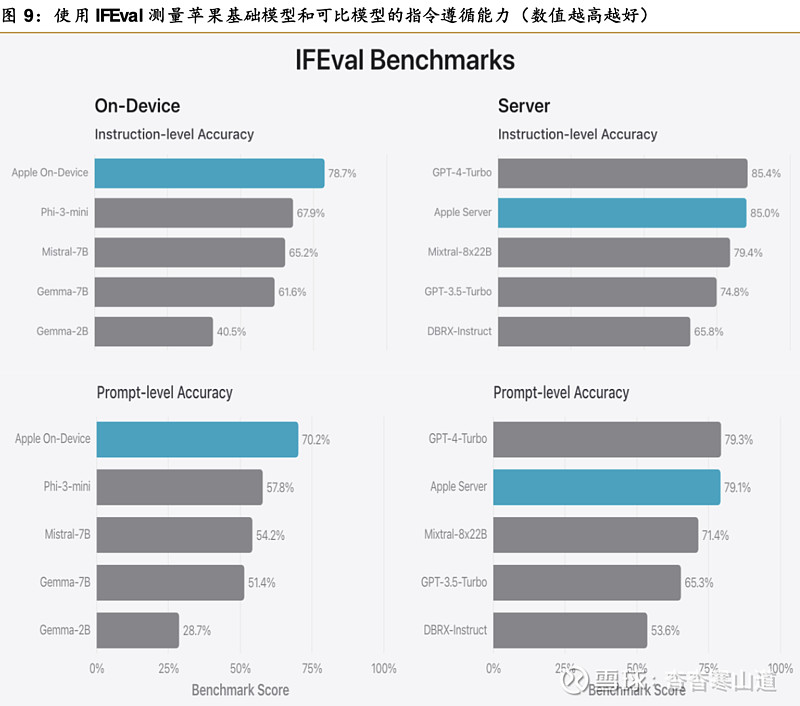

为了进一步评估模型能力,苹果使用Instruction-Foll owi ng E val (IFE val) 基准测试来比较苹果模型与可比模型的指令遵循能力。通过测试结果可见,苹果设备端和云端模型相比可比开源模型和商业模型能更好地遵循详细指令的要求

苹果在内部摘要和撰写基准测试中评估了模型的写作能力,包括各种写作指令。通过测试结果可见,相比可比开源模型和商业模型,苹果设备端和云端模型在摘要和写作能力表现方面更好。

在WWDC2024上发布的苹果基础模型和适配器构成了Apple Intelli gence的基础。Apple Intelligence是一个全新的个人智能系统,深度集成到iPhone、iPad和Mac中,通过多项基准测试可见,其在语言、图像、动作和个人上下文方面提供了强大的能力。在这个过程中,苹果的多个生成式模型发挥了极大的作用;

2.2MM1模型

2024年3月,苹果正式公布自家的多模态大模型MM1。MM1由密集模型和混合专家(MoE)变体组成,具有300亿、70亿、30亿参数等多个版本。MM1不仅在预训练指标中实现最优性能SOTA,在一系列已有多模态基准上监督微调后也能保持有竞争力的性能。

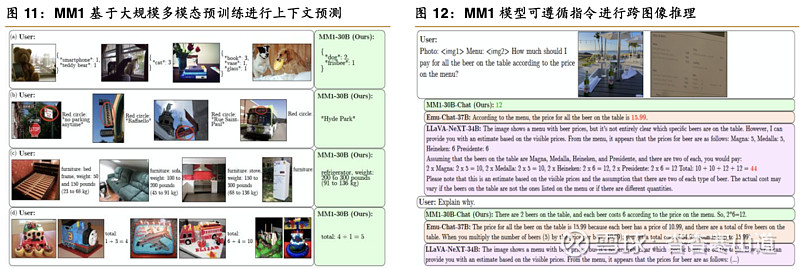

得益于大规模多模态预训练,MM1模型在上下文预测、多图像和思维链推理等方面表现不错。MM1模型在指令调优后展现出强大的少样本学习能力。在几乎所有基准测试中,苹果的MoE模型比密集模型取得更好的性能,显示MoE进一步扩展的巨大潜力

由于其大规模多模态预训练,MM1可进行上下文预测。这使得MM1能够:a)计数对象并遵循自定义格式;b)引用图像的部分并执行OCR;c)展示关于日常物品的常识和词汇知识;d)执行基本的数学函数。

MM1模型可以遵循指令进行跨图像推理。示例和图像来自VILA;当使用思维链提示时,VILA能够正确回答。

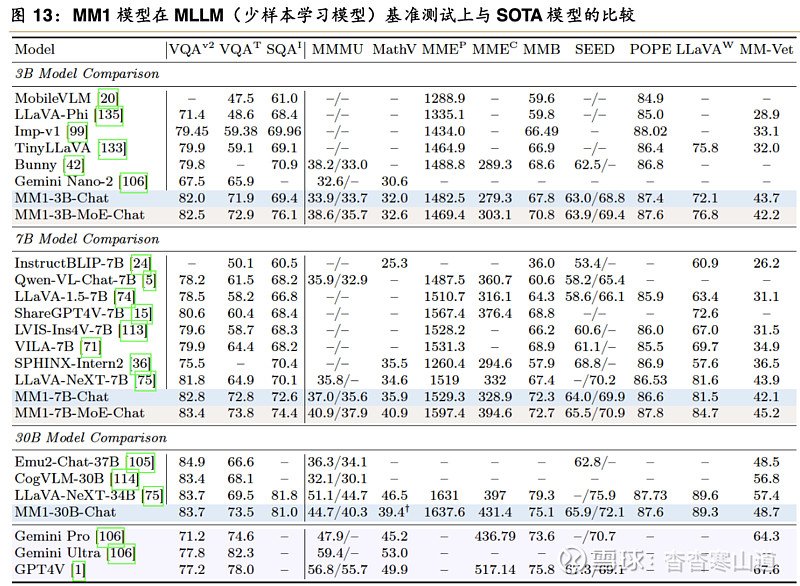

通过与市面主流的AI大模型比较,MM1模型在领域特定微调(SFT)之后有较为优异的表现:

1)MM1-3B-Chat和MM1-7B-Chat的表现超过了所有列出的同等规模的模型。MM1-3B-Chat和MM1-7B-Chat在VQAv2、TextVQA、ScienceQA以及更近期的基准测试(MMMU和MathVista)上显示出特别强的性能。

2)探索了两个混合专家模型(MoE):(i)具有64个专家的3B-MoE;(ii)具有32个专家的7B-MoE。苹果的MoE模型在几乎所有基准测试上都比对应的密集型模型表现更好。这表明MoE在进一步扩展方面具有巨大的潜力。

3)对于30B模型规模,MM1-30B-Chat在TextVQA、SEED和MMMU上超过Emu2-Chat-37B和CogVLM-30B。与同期的LLaVA-NeXT相比,也取得了有竞争力的性能。

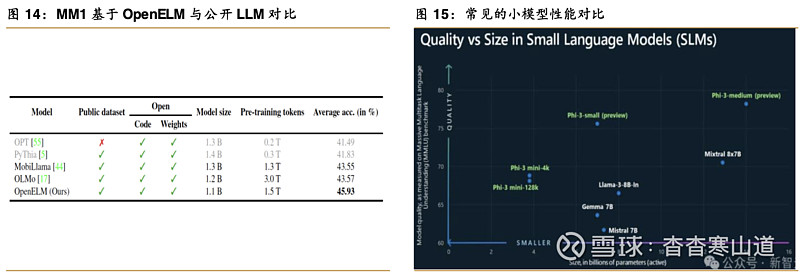

2.3OpenELM模型

4月26日,苹果宣布了更大的端侧AI推进,推出全新的开源大语言模型OpenELM。OpenELM包含2.7亿、4.5亿、11亿和30亿个参数的四种版本,定位于超小规模模型,可在手机和笔记本电脑等终端设备上运行文本生成任务。同时,苹果开源了OpenELM模型权重和推理代码、数据集、训练日志、神经网络库CoreNet。

OpenELM使用了“分层缩放”策略,来有效分配Transformer模型每一层参数,从而提升准确率。在约10亿参数规模下,OpenELM与OLMo相比,准确率提高了2.36%,同时需要的预训练token数量减少了50%。

OpenELM的基准测试(数据类型BFloat16)在工作站(配备英特尔i9-13900KF CPU、RTX 4090 GPU,24GB DDR5内存),以及M2 Max MacBook Pro(64GB内存)运行。

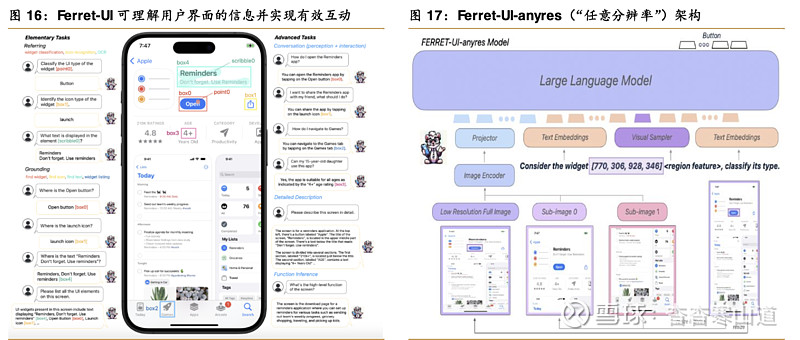

2.4Ferret-UI模型

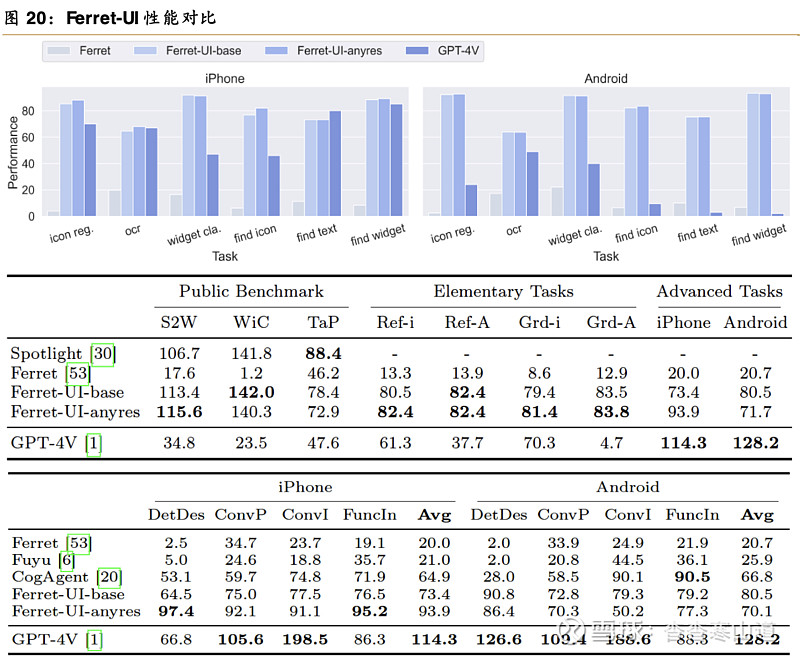

4月8日,苹果展示了多模态模型Ferret-UI。Ferret-UI模型可以理解手机屏幕上的应用程序内容,专为增强对移动端UI屏幕的理解而定制,其配备了引用(referri ng)、定位(grounding)和推理(reasoning)功能。Ferret-UI具备了解决现有大部分通用多模态大模型所缺乏的理解用户界面(UI)屏幕并与其有效交互的能力。

Ferret-UI可执行从基本到复杂任务等11种任务。它能在移动UI屏幕上使用灵活的输入格式(点、框、涂鸦)执行指代任务(例如控件分类、图标识别、OCR)和定位任务(例如查找控件、查找图标、查找文本、控件列表)。这些基本任务为模型提供了丰富的视觉和空间知识,使其能在粗略和精细级别(例如各种图标或文本元素之间)区分UI类型。这些基础知识对于执行更高级的任务至关重要。具体来说,Ferret-UI不仅能在详细描述和感知对话中讨论视觉元素,还可在交互对话中提出面向目标的动作,并通过功能推理推断出屏幕的整体功能;

Ferret-UI建立在Ferret的基础上。Ferret是一个MLLM,在不同形状和细节水平的自然图像中实现空间参考和基础。无论是点、框还是任何自由形式的形状,它都可以解释相应区域或对象并与之交互。Ferret包含一个预训练的视觉编码器(例如CLIP-Vi T-L/ 14)和一个Decoder Only的语言模型(例如Vicuna)。此外,Ferret还采用了一种独特的混合表示技术,该技术将指定区域转换为适合LLM处理的格式。本质上,空间感知视觉采样器旨在熟练地管理不同稀疏度级别的区域形状的连续特征。

虽然Ferret-UI-base是基于Ferret的架构,但Ferret-UI-anyres包含额外的细粒度图像功能。特别是,预训练的图像编码器和投影层为整个屏幕生成图像特征。对于基于原始图像长宽比获得的每个子图像,都会生成额外的图像特征。对于具有区域参考的文本,视觉采样器会生成相应的区域连续要素。LLM使用全图像表示、子图像表示、区域特征和文本嵌入来生成响应

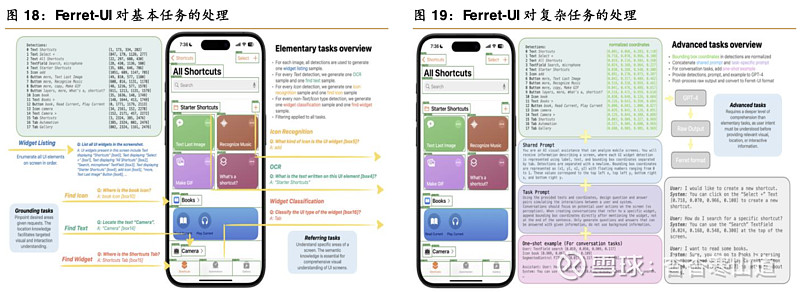

Ferret-UI对基本任务的处理流程:UI检测器输出所有检测到的元素,以及每个元素的类型、文本和边界框。这些检测用于为基本任务创建训练样本。对于定位任务,使用所有元素检测来创建一个用于控件列表的样本,而其余任务一次专注于一个元素。将元素分为图标、文本和非图标/文本控件。对于每种类型,创建一个指代样本和一个定位样本。

Ferret-UI对复杂任务的处理流程:首先从检测输出中归一化边界框坐标,然后将检测、提示和可选的单次示例发送到GPT-4。对于详细的描述和函数推理,将生成的响应与预先选择的提示配对,以训练Ferret-UI。对于对话任务,直接将GPT-4输出转换为多回合对话

通过精心设计“任意分辨率”(anyres)以适应各种屏幕宽高比,以及策划包含广泛的基本和高级UI任务的训练样本,Ferret-UI在引用、定位和推理方面表现出显著的熟练程度。这些增强能力的引入预示着在众多下游UI应用中或将取得重大进步,从而扩大Ferret-UI在这一领域所能提供的潜在益处

Apple Intelligence融入iOS、macOS、iPadOS层面,于应用中直接调用AI能力。用户无需在单独的AI助手工具与应用之间来回切换。

作为苹果终端的AI核心交互入口,Siri开启了智能助手新时代。Apple Intelli gence赋能使得Siri变得更加智能。凭借全新设计、更丰富的语言理解能力,以及便捷输入Siri的能力,用户与Siri的交流比以往任何时候都更加自然。Siri具备对用户个人环境的感知、在应用程序中和跨应用程序采取行动的能力,以及有关设备功能和设置的产品知识等,为用户提供帮助。

Siri采用全新设计,更深入地融入了系统体验,优雅的发光环绕在屏幕边缘。Siri可为终端设备的功能和设置提供循序渐进的指导。更丰富的语言理解和增强的语音使得用户与Siri的交流更加自然。

Siri未来将具备屏幕感知功能,可以理解屏幕上的内容并采取行动。

了解用户的个人环境,Siri能够以独有的方式帮助用户查找信息。使用Siri在应用程序中和应用程序之间无缝地采取行动。

苹果智能技术驱动新的写作工具,帮助用户在几乎所有书写场合找到最恰当的措辞。借助增强的语言能力,用户可在几秒内总结整场讲座,获取冗长群聊的简短版本,并通过优先通知来减少不必要的干扰。这些功能均能在应用界面下即时完成

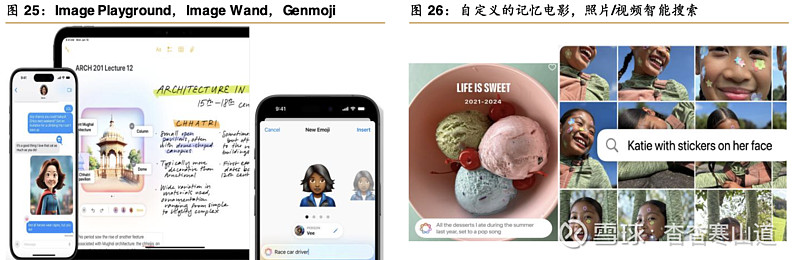

多模态能力:Apple Intelligence可提供更人性化的视觉表达方式。创造个性化的原创图像和全新的Genmoji;将粗略的草图转换为相关的图像,用图像棒补充笔记;根据用户提供的描述制作一部自定义的记忆短片

Image Playground根据用户描述、甚至照片库中的人,在几秒内生成原创图像并可共享。

Image Wand可在Notes中将粗略草图转换为相关图像;在草图周围画一个圆圈,Image Wand将分析其周围的内容,以产生互补的视觉效果;用户可以圈出一个空白区域,Image Wand将使用周围的上下文来创建图片。

可将相关照片整理成一部有用户自己叙事弧线的电影。根据用户要查找的内容的要求,在照片应用程序中搜索照片和视频。Apple Intelligenc e可以在视频剪辑中找到符合用户搜索描述的特定时刻,并将其带到正确的位置。

Apple Intelligence跨应用的信息整合能力。通过为照片、日历、行程和文件等内容创建语义索引,Apple Intelligenc e能从各种应用中整理和提取信息,找出相关个人数据并提供给AI模型,模型能在充分了解用户背景和个人情境的基础上更好地提供智能服务。也就是说,模型能发现并理解跨APP之间的信息(早期以原生应用为主,部分第三方亦会支持调用),具备跨平台信息处理能力。而这得益于苹果在系统+模型+芯片+终端的一体化优势

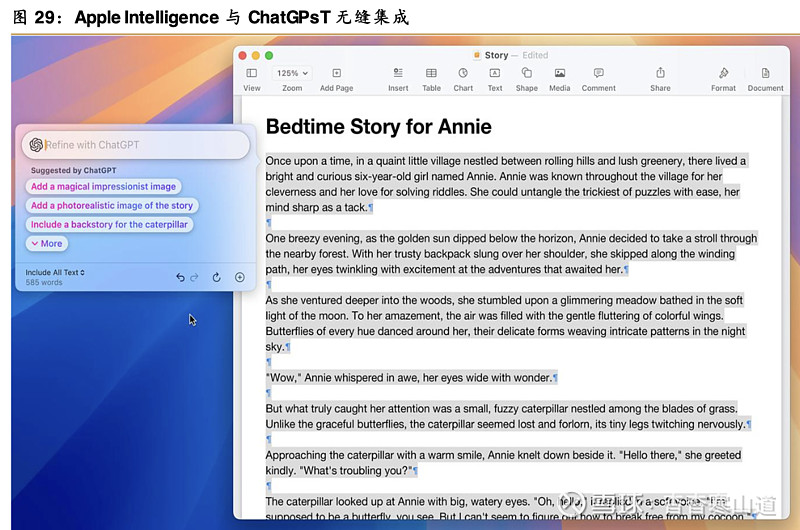

Apple Intelligence与OpenAI的ChatGPT无缝集成。随着OpenAI的ChatGP T集成到Siri和写作工具中,用户可以获得更多的专业知识,而无需在工具之间切换。Siri可以利用ChatGP T处理某些请求,包括有关照片或文档的问题。使用“在写作工具中创作”,用户可以从头开始创建和演示原创内容。用户可以控制何时使用ChatGP T,并且在共享用户的任何信息之前都会被询问。用户可以免费访问ChatGP T,而无需创建帐户。GPT Plus用户可以连接帐户以访问GPT中的付费功能。

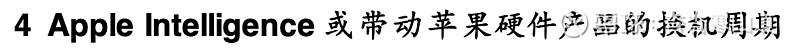

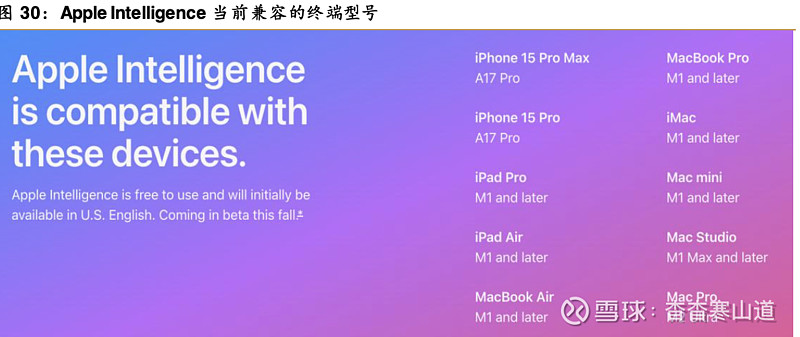

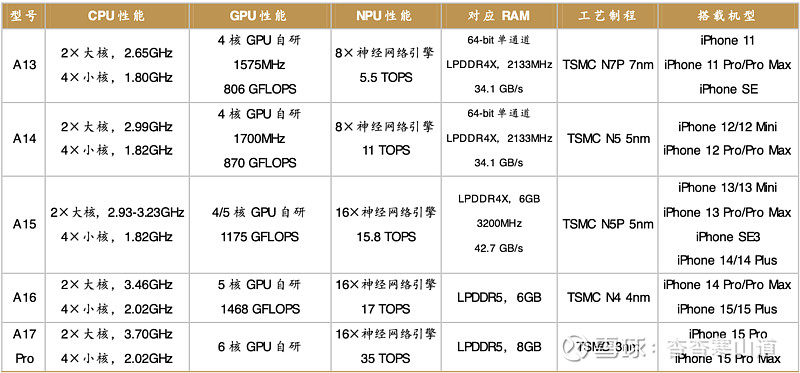

根据苹果官网所示,支持Apple Intelligence端侧运算的芯片和终端要求如下:

iPhone目前仅支持A17 Pro,满足要求的仅iPhone 15 Pro/Pro Max;

Mac和iPad端支持M1及以上版本的芯片,覆盖了苹果所有PC ARM芯片,近几年基于M芯片的苹果Mac、iPad基本都支持

由于对旧款硬件产品的支持有限,Apple Intelligence或带动苹果硬件产品线的换机周期。特别是iPhone支持的旧款机型较少,iPhone或存在更强的换机需求

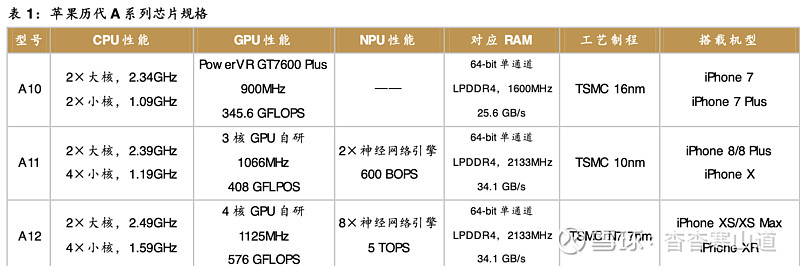

由于本地运行AI模型对算力和内存有一定的要求,新一代AI手机需具备至少30 TOPS性能的NPU能运行AI模型,内存至少8GB容量,而目前仅有iPhone 15 Pro/Pro Max支持运行Apple Intelli gence。从历史上的销售来看,每次较大力度的产品创新可以促进iPhone的销量,Apple Intelligenc e或带动苹果iPhone的换机周期。今年9月份iPhone 16的新机发布会值得期待。

根据Counterpoi nt的数据统计,iPhone 15 Pro/Pro Max合计占据iPhone 24Q1总销量的45%。根据CCS Insight统计,iPhone的全球整体保有量达到13亿,理论上存量用户是未来AI iPhone换机的潜在主力

由于M芯片强劲的算力和内存性能,Mac和iPad对Apple Int elligence的支持较大,搭载M1及以上版本芯片的终端基本都支持

苹果自2020年11月开始推出搭载M芯片的Mac和iPad。考虑到最长十年的使用寿命,非M芯片的Mac的保有量至少1.98亿台,非M芯片的iPad的保有量至少5.38亿台

软件服务业务是苹果近十多年来增长最快的业务之一,FY2006-FY 2023的年复合增速达到21.4%。软件服务业务主要包含了App Store、Apple Care、iCloud、音乐、TV、游戏、Apple Pay等产品和服务

。Apple one以较低的资费(19.95美元/月、25.95美元/月、37.95美元/月)捆绑最多6个苹果账户订阅,其中包括高达2TB的iCloud+存储空间。通过家庭计划或卓越理财计划,用户最多可邀请5个人加入,并在他们的所有设备上进行私人访问。

预计未来更广泛的非英语语言功能、与第三方应用程序的命令/控制集成、以及可能增加的AI订阅服务将为软件服务业务带来更多价值

此外,长期来看,苹果原生APP与AI的深度融合,未来或有机会扩展更多的AI应用付费市场,有利于提升苹果在软件业务领域的价值量

关键假设:假设1:2024财年手机出货见底,2025-2026财年AI手机或推动iPhone产品线新一轮创新周期,带动销售增长;

假设2:Mac产品线在搭载更强芯片平台和AI PC推动下,未来三年复合增长率为6%;

假设3:考虑到iPad的换机周期,2025-2026财年复合增速为1.5%。Watch和AirPods因需求饱和预计出货放缓,2026财年随着新一代MR设备上市,带动其他硬件重回增长态势。

假设4:随着硬件产品保有量和付费率的提升,软件服务业务未来三年复合增长率达10%。

基于以上假设,我们预测公司2024-2026财年分业务收入如下表