可以注意到,视频中出现车辆操作异常的时候,其实视觉感知都是没问题的,问题是出在驾驶行为、尤其是转向行为的自动决策上。

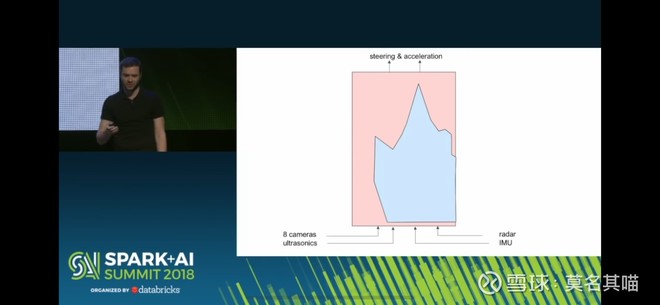

在下图Andrej的ppt中可以看到,当年特斯拉正在逐步把手工编写的逻辑替换成机器通过训练习得的操作逻辑,而steering这部分是替换的比较慢的。

我猜测,这些年里特斯拉autopilot团队的主要精力放在了感知上,而没有怎么改进车辆操作。车辆操作部分的很多逻辑可能还是手写的。所以最终呈现的结果,就是视觉感知非常棒,但车辆操作还有些莫名其妙的低级错误。感知的提升使得对车道线、道路交通的其他参与者有了更精确和稳定的识别,于是非复杂路况下,手工编写的代码表现得更平滑了(输入的数据更少跳跃)。然而相对复杂的路况下,手工代码无法应付复杂状况的缺陷并不能通过出色的感知来弥补,这就体现在车辆的莫名漂移和过度转向等等。

感知这一块特斯拉确实完成了很多非常有挑战性的工作,比如距离信息的计算,从2D labeling转向4d labeling等等,更不用说各种corner case。而Beta 9相比之前的版本在感知上也有非常大的变化,实现了包括八个摄像头的融合、去除雷达等新功能。而出色的感知又是车辆操作不可或缺的基础,所以特斯拉集中资源解决感知的问题是完全可以理解的。

目前来看,感知这一块特斯拉已经有了长足的进步,也许我们可以期待一下车辆操作部分的更快改善了。