作者:龚进辉

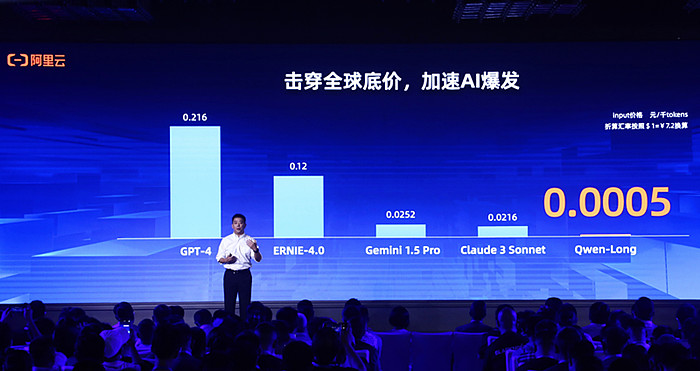

今年以来,阿里云总是带给业界惊喜。继2月底宣布100多款产品全线降价20%后,今天它又抛出重磅炸弹:通义千问GPT-4级主力模型Qwen-Long,API输入价格从0.02元/千tokens降至0.0005元/千tokens,直降97%。这意味着,1元可以买200万tokens,相当于5本《新华字典》的文字量。

据悉,Qwen-Long是通义千问的长文本增强版模型,性能对标GPT-4,上下文长度最高达1千万,降价后约为GPT-4价格的1/400,也比字节跳动豆包主力模型0.0008元/千tokens的定价更便宜,真正击穿全球底价,带动大模型定价进入“厘时代”。

除了输入价格降至0.0005元/千tokens,Qwen-Long输出价格也直降90%至0.002元/千tokens。相比之下,国内外厂商GPT-4、Gemini1.5 Pro、Claude 3 Sonnet和Ernie-4.0每千tokens输入价格分别为0.22元、0.025元、0.022元和0.12元,均远高于Qwen-long。

通义千问本次降价共覆盖9款商业化和开源系列模型。其中,前不久发布的通义千问旗舰款大模型Qwen-Max也加入到降价行列,API输入价格降至0.04元/千tokens,降幅达67%。它是目前业界表现最好的中文大模型,在权威基准OpenCompass上性能追平GPT-4-Turbo,并在大模型竞技场Chatbot Arena中跻身全球前15。

随着大模型性能逐渐提升,AI应用创新正进入密集探索期,2024年被认为是AI应用元年,但推理成本过高依然是制约大模型规模化应用的关键因素。基于此,阿里云才会大力推动大模型降价,在武汉AI智领者峰会现场,阿里云智能集团资深副总裁、公共云事业部总裁刘伟光宣布上述重磅举措。

他表示,“作为中国第一大云计算公司,阿里云这次大幅降低大模型推理价格,就是希望加速AI应用的爆发。我们预计未来大模型API的调用量会有成千上万倍的增长。”在刘伟光看来,不管是开源模型还是商业化模型,公共云+API将成为企业使用大模型的主流方式。

据我观察,过去大模型推理成本下降,很大程度要依赖算力升级,但从2023年开始,推理成本的下降,则是在算力没有升级的情况下完成的,包括架构创新、推理优化、系统升级甚至推理集群计算架构方面等。这意味着,除了算力升级之外,模型优化本身也拥有较大空间。

而这恰恰是阿里云优势所在,它可以从模型自身和AI基础设施两个层面不断优化,追求极致的推理成本和性能,好处也显而易见。随着大模型从卷技术向卷应用转变,谁能解决推理成本过高这一难题,谁就能打开AI应用的开关,推动大模型规模化应用。

所以,阿里云才会放出大模型击穿全球底价这一大招。此前,智谱AI、豆包大模型也纷纷宣布降价,大模型价格卷起来了!在我看来,这轮大模型降价潮的背后,是各大玩家希望进一步抢占市场,从而加速AI应用的商业化落地。纵观科技发展历程,成本下降刺激需求爆发是一大铁律。可以预见的是,推理成本下降,必然将带动AI应用加速普及,全力投入的阿里云或成最大赢家。@今日话题