AI创投周报是阿尔法公社推出的聚焦于以生成式AI为代表的人工智能新浪潮的创投资讯周报。阿尔法公社发现和投资非凡创业者(Alpha Founders),相信非凡创业者们在技术、商业和社会方面的巨大推动力,他们指引着创投生态的风向。

本图由“千象”(网址:网页链接)生成

本周,我们观察到以下AI领域的新动向和新趋势:

1.xAI获得Valor、a16z和红杉资本领投的60亿美元B轮融资,并计划打造10万张GPU级别的AI超算。

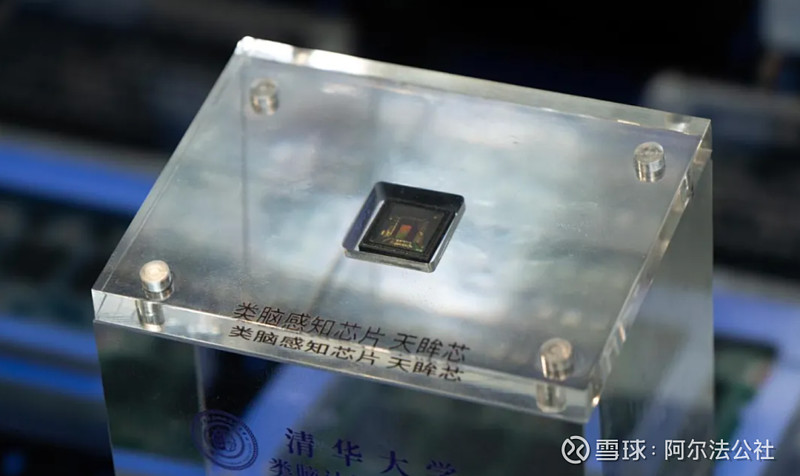

2.清华推出世界首个类脑互补视觉芯片“天眸芯”,登上Nature封面,它突破了传统视觉感知的瓶颈,标志着我国在类脑计算和类脑感知方面取得了重大突破。

3.Meta FAIR实验室提出了名为CoPE的新型位置编码方法,解决了Transformer模型处理复杂序列数据时面临的关键问题,预示着未来AI技术在理解和处理复杂数据结构方面将有更大的突破。

如果您对人工智能的新浪潮有兴趣,有见解,有创业意愿,欢迎扫码添加“阿尔法小助理”,备注您的“姓名+职位”,与我们深度连接。

人工智能产品和技术的新突破

1.Meta发布的CoPE论文爆火:Transformer模型根本缺陷的解决之道

近期,Meta的FAIR实验室发表了题为《Contextual Position Encoding: Learning to Count What’s Important》的论文,提出了一种名为CoPE(Contextual Position Encoding)的新型位置编码方法,有望解决当前大语言模型(LLM)在处理复杂序列数据时面临的关键问题,迅速在AI领域引起广泛关注。

Transformer架构作为LLM的核心,依赖于注意力机制,但这种机制本身并不包含顺序信息,因此需要额外的位置编码来提供数据的顺序性。传统的PE方法基于token位置,无法有效处理像句子这样更高级别的语义单元。CoPE通过结合上下文信息,允许模型根据内容选择性地编码位置,从而使得模型能够更精确地理解和处理输入数据的结构和语义。

CoPE的工作原理是首先使用上下文向量确定要计数的token,然后计算门值来确定每个token相对于当前token的相对位置。与传统的基于token计数的位置编码不同,CoPE的位置值可以是分数值,提供了更高的灵活性和精确度。通过这种方式,CoPE能够实现对句子、名词等语义单元的精确定位,这对于提高模型在自然语言处理任务中的表现具有重要意义。

在一系列实验中,CoPE在处理选择性复制、计数任务以及语言和编码任务中显示出了相对于传统方法的显著优势,尤其是在处理分布外数据和需要高泛化能力的任务上。

CoPE的出现被视为Transformer模型发展的一个重要里程碑,预示着未来AI技术在理解和处理复杂数据结构方面将有更大的突破。

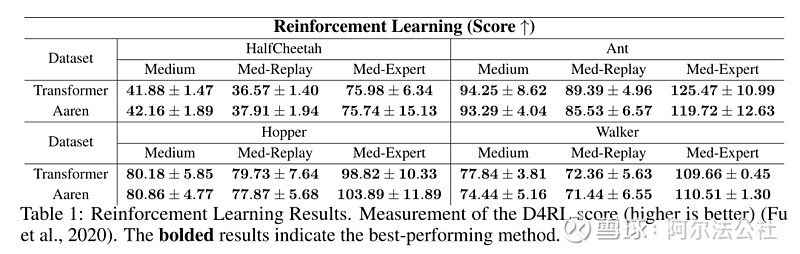

2.Bengio等人新作:注意力可被视为RNN,新模型媲美Transformer

序列建模在强化学习、时间序列分类等广泛应用中具有重要影响力。近年来,得益于其高性能的并行处理架构,Transformer在序列建模中取得了显著突破。然而,Transformer在推理时的计算开销较大,尤其是在移动和嵌入式设备等低资源环境中。

为了应对这一挑战,Borealis AI和蒙特利尔大学的研究者提出了一种新模型Aaren(Attention as a Recurrent Neural Network)。图灵奖得主 Yoshua Bengio也出现在作者一栏里。

这项研究表明,Transformer中的注意力机制可视为一种特殊的RNN,具有高效计算的多对一RNN输出能力。基于这一发现,研究者提出了一种基于并行前缀扫描算法的新的注意力公式,能够高效地计算多对多RNN输出。

新模型Aaren结合了Transformer的并行训练优势和RNN的高效更新能力。它不仅在训练时具备高效计算性能,还在推理时内存需求恒定,不随token数量线性增长。实验结果显示,Aaren在38个数据集上的表现与Transformer相当,但在时间和内存方面更加高效。

3.世界首个类脑互补视觉芯片问世, 清华“天眸芯”登Nature封面

清华大学施路平教授团队发布了世界首款类脑互补视觉芯片“天眸芯”(Tianmouc),这是基于人类视觉系统灵感的一种新范式。该芯片能以极低带宽和功耗采集图像信息,突破了传统视觉感知的瓶颈,成功应对开放世界中的极端场景挑战。这项研究成果登上了Nature封面,标志着我国在类脑计算和类脑感知方面取得了重大突破。

天眸芯采用基于视觉原语的互补双通路类脑视觉感知范式,模拟人类视觉系统的工作原理。天眸芯采用90纳米背照式CMOS技术制造,包含混合像素阵列和并行异构读出架构,其像素阵列结合了不同感光细胞的特性,实现了高动态范围、高精度和高帧速的视觉信息采集。

天眸芯在性能指标上表现优异,包括高量子效率、高动态范围和快速响应能力,其功耗和带宽消耗显著低于传统传感器。它在自动驾驶、具身智能等领域具有广泛应用前景,其独特的设计使其能够在复杂多变的环境中提供高效、精准和鲁棒的视觉感知。

4.填补AlphaFold3空白,字节跳动提出蛋白质构象生成扩散模型—CONFDIFF

在探索蛋白质的动态构象分布方面,传统分子动力学模拟方法昂贵且耗时,而深度学习模型如AlphaFold3也主要集中在静态结构预测。字节跳动研究团队提出了一种新的物理信息引导的蛋白质构象生成扩散模型—CONFDIFF,通过预测中间时刻的力场与能量来引导模型生成高质量构象,该研究成果已被ICML 2024录用。

CONFDIFF利用物理知识引导生成模型,与真实世界对齐。相比传统方法,该模型显著加速了构象生成过程,例如在快速折叠蛋白质和牛胰蛋白酶抑制剂(BPTI)数据集上,CONFDIFF展示出优越的构象生成能力,生成样本多样且准确。

CONFDIFF构建一个生成扩散模型,通过预测主链原子坐标和主链朝向来构建蛋白质构象。该模型利用目标序列的预训练表示,引导生成多样化且符合结构与序列约束的构象。

这个CONFDIFF模型,为蛋白质动态构象预测提供了新的解决方案,有助于扩展蛋白质结构预测从静态走向动态,为药效预测、药物设计、新靶点发现等提供了理论基础和技术支持,进一步推动了AI在科学研究和药物开发中的应用。

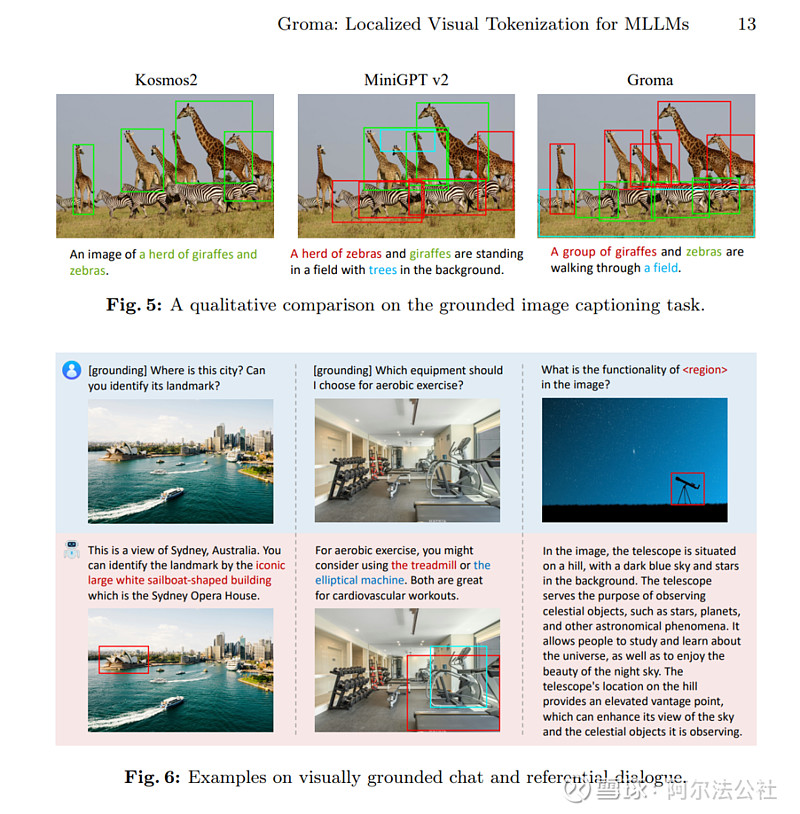

5.港大字节提出多模态大模型新范式,模拟人类先感知后认知,精确定位图中物体

香港大学和字节跳动提出了一种名为Groma的新范式,通过区域性图像编码提升多模态大模型的感知定位能力。

现有的多模态大模型在视觉任务上具有强大的认知理解能力,但在图像中的物体定位上存在局限,限制了其在图像编辑、自动驾驶和机器人控制等领域的应用。Groma通过引入区域编码,将定位转移到vision tokenizer中,充分利用其空间理解能力,无需外接专家模型,提升了定位的鲁棒性和准确性。

具体来说,Groma利用Region Proposer定位潜在物体,通过Region Encoder将定位区域编码成region token,大语言模型根据region token的语义判断对应区域,并在输出中插入region token,实现visually grounded conversation。

Groma使用超过8M的数据预训练Region Proposer,涵盖常见物体及其组成部分。分离式设计使得Groma在降低计算量的同时不损失定位性能。

实验结果显示,Groma在传统的Grounding Benchmarks上超越了MiniGPT-v2和Qwen-VL,并在VQA Benchmark (LLaVA-COCO)上验证了其对话和推理能力。

在可视化对比中,Groma表现出了更高的recall和更少的幻觉。Groma支持融合对话和定位能力的referential dialogue和grounded chat,通过解耦感知和认知,提供了一种新思路,既符合人类视觉过程,也避免了重新训练大语言模型的计算开销。

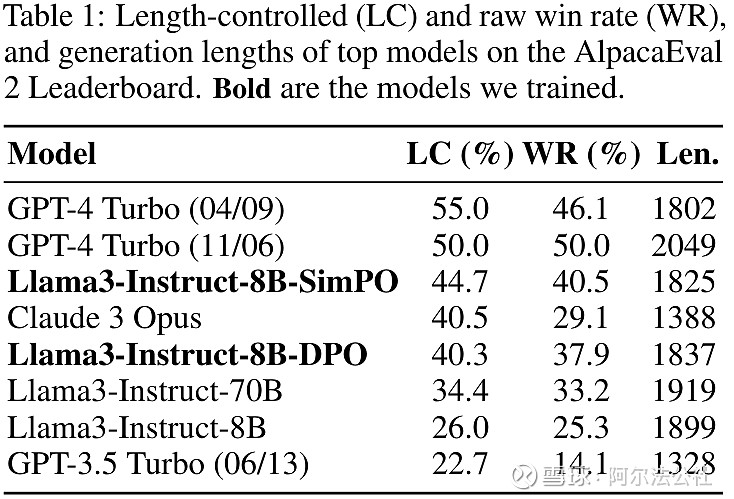

6.全面超越DPO:陈丹琦团队提出简单偏好优化SimPO,还炼出最强8B开源模型

为了使大语言模型(LLM)与人类的价值和意图对齐,学习人类反馈至关重要。一种有效的方法是根据人类反馈的强化学习(RLHF)。尽管RLHF方法结果出色,但其多阶段过程带来了一些优化难题。直接偏好优化(DPO)通过参数化RLHF中的奖励函数来直接根据偏好数据学习策略模型,简化了这一过程。然而,DPO在训练和推理之间存在差异,影响了性能。

弗吉尼亚大学的助理教授孟瑜与普林斯顿大学在读博士夏梦舟和助理教授陈丹琦提出了一种新的算法—SimPO(简单偏好优化)。

SimPO核心在于将偏好优化目标中的奖励函数与生成指标对齐,包含两个主要组件:(1)在长度上归一化的奖励,计算方式是使用策略模型的奖励中所有token的平均对数概率;(2)目标奖励差额,用以确保获胜和失败响应之间的奖励差超过这个差额。

SimPO不需要参考模型,比DPO更轻量更易实现,而且SimPO在不同训练设置和多种指令遵从基准上性能优于DPO。

团队基于Llama3-8B-instruct构建的模型在AlpacaEval 2和Arena-Hard基准上表现优异,成为目前最强大的8B开源模型。实验结果表明SimPO比其他偏好优化方法具有更好的性能和效率。

人工智能初创公司的新融资

1.马斯克的xAI公司从Valor、a16z和红杉资本获得60亿美元B轮融资,并将用10万张H100打造AI超算中心

埃隆·马斯克的人工智能初创公司xAI宣布,在新一轮融资中筹集了60亿美元,Valor Equity Partners、Vy Capital、Andreessen Horowitz、红杉资本、富达投资、塔拉勒·本·阿勒瓦利德王子和王国控股等投资者参与了xAI的B轮融资。

大模型厂商的竞争,除了拼技术外,现在还需要拼资金,拼算力,无论是OpenAI,Anthropic,Meta还是Google,都投入了天量的资金训练模型。如果想继续留在牌桌上,就必须持续融资。xAI计划将新融资轮的资金用于将其首批产品推向市场,构建先进的基础设施,并加速未来技术的研究与开发。

今年4月,xAI发布了新的Grok 1.5模型,并允许X上的Premium用户访问这个模型支持的聊天机器人。此外,这家xAI在4月预览了Grok的多模态能力。今年早些时候,xAI开源了Grok模型,但没有提供任何训练代码。

说到基础设施,xAI宣布将投入巨资建造一个超算中心,确保Grok 2及其后续版本的训练。这个“超级计算工厂”预计于2025年秋季建成,规模将达到目前最大GPU集群的四倍。马斯克训练Grok 2需要大约2万个NVIDIA H100 GPU,而Grok 3及其更高版本将需要10万个H100芯片。

2.AI搜索创企Perplexity获BVP领投2.5亿美元融资,估值飙升至30亿美元

AI搜索引擎初创企业Perplexity将完成自己2.5亿美元的第四轮融资,此轮融资由Bessemer Venture Partners领投,老股东Databricks、NEA、AIX Ventures等也参与其中。这轮融资使公司估值飙升至30亿美元,相较于年初提升了三倍。

作为AI搜索领域的领头羊,据The Information报道,Perplexity的订阅产品年收入已超过2000万美元,较10月份的300万美元有了显著增长。但是AI搜索这种产品形态,无论是谷歌,OpenAI还是微软,都已经有相对成熟的产品,尤其是谷歌,更是重兵投入,Perplexity面临激烈竞争。面对这些竞争,Perplexity可能需要在技术和产品体验上持续精进,保持自己的差异化优势。

Perplexity成立于2022年8月,由前OpenAI研究员Aravind Srinivas和Meta研究科学家、现任Perplexity首席技术官Denis Yarats等人共同创立。

3.Suno获1.25亿美元融资,旨在成为音乐创作的“ChatGPT”

官方网站:suno.com

音乐AI初创公司Suno近日获得1.25亿美元的新融资,由Lightspeed Venture Partners、Nat Friedman和Daniel Gross、Matrix以及Founder Collective等知名风投机构或投资人领投。Suno希望借助这笔资金改变音乐的创作、消费和盈利方式。

Suno拥有自己的开源音频生成模型Bark,并搭建了自己的音乐生成平台,能够根据用户提供的文本提示生成逼真的歌曲,包括人声和乐器,该平台还可以生成纯乐器音乐或包含歌词的完整歌曲。

在商业合作方面,Suno与微软合作,将其音乐生成技术集成到Microsoft Copilot中,为用户提供更便捷的创作工具,在其产品发布后的八个月内,已有1000万人使用Suno生成音乐。

与此同时,整个AI音乐行业都面临来自音乐产业的版权挑战,Suno声称其训练数据经过仔细处理,以避免侵犯版权。

Suno由Mikey Shulman(CEO)和Georg Kucsko(CTO)联合创立,Shulman拥有哈佛大学的量子物理学博士学位,是麻省理工学院斯隆管理学院的讲师,此前在Kensho Technologies担任机器学习主管。Kucsko的履历和Mikey Shulman几乎一模一样,他也是麻省理工学院斯隆管理学院的讲师,毕业于哈佛大学,显然这两位创始人有长期的合作和信任关系。

4.人工智能数据处理方案提供商Coactive AI获a16z和BVP参投的3000万美元B轮融资

官方网站:coactive.ai

Coactive AI是一家专注于视觉数据处理的人工智能公司,它近日获得Cherryrock Capital、Emerson Collective领投,Andreessen Horowitz, Bessemer Venture Partners, Greycroft参投的3000万美元B轮融资。我们从2023年3月就关注到这家公司,a16z、BVP以及李飞飞都是它的前几轮融资投资人。

Coactive AI通过结构化非结构化数据,帮助企业从图像和视频数据中提取有价值的见解。它的核心业务是为企业提供图像和视频数据的管理和分析工具,帮助用户快速搜索和分类视觉内容。它通过机器学习自动生成准确的图像和视频元数据,解决了传统元数据不完整、不准确的问题。

它还提供无需标签即可通过关键词或短语搜索视觉内容的功能,大大提高了数据检索效率。此外,它丰富的分析工具,帮助用户解答有关视觉数据的问题,如趋势分析、类别分布等。

Coactive AI由Cody Coleman(师从Databricks的联合创始人Matei Zaharia,是MLPerf 和MLCommons的创始成员)和Will Gaviria Rojas共同创立。

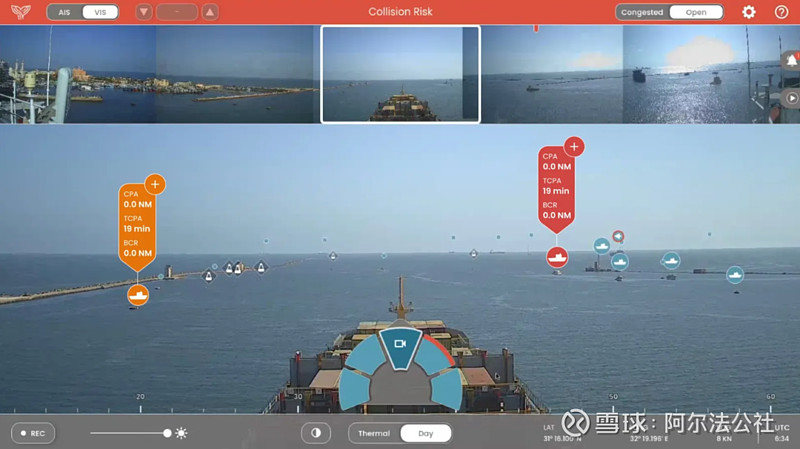

5.商业船舶自动驾驶技术公司Orca AI获2300万美元融资

官方网站:网页链接

Orca AI是一家商业船舶自动驾驶技术公司,近日它获得由OCV Partners和MizMaa Ventures领投的2300万美元新融资,使其总融资额接近4000万美元。

船舶自动驾驶的市场规模预计将从2023年的44.6亿美元增长到2024年的53.3亿美元。Orca AI的技术能使自动驾驶的商业船舶在拥挤水域航行。

根据2023年试验的结果,Orca声称其系统非常精确,能够将“开放水域中的近距离遭遇”减少33%,“交叉事件”减少40%,覆盖了1500万海里。(根据欧洲海事安全机构的报告,2022年有超过2500起重大海上事件。)

这套系统能让每艘船每年节省10万至30万美元的燃料(减少3%至5%的燃料消耗)。此外,Orca AI表示其技术去年在1000艘船上实现了72716吨的二氧化碳减排。

Orca AI的首席执行官和联合创始人Gross在接受采访时表示:“当你谈论远洋船舶时,我们将在不久的将来看到没有船员的船舶航行。与此同时,你可以优化和自动化航行的许多部分,减少工作量,也减少人员数量。你可以优化燃料消耗、排放和预计到达时间(ETA),并提高安全性。所以正在建设一个为船舶本身服务的平台。”

Gross表示,Orca的平台将所有数据上传到云端,为船队管理者提供监控工具和能力。“这意味着他们可以操作的不是一艘船,而是整个船队。所以你可以将其视为一个半自动化船队的运营平台。”

Orca AI与MSC、NYK、Maersk和Seaspan等全球航运公司合作,在海上自动导航这个赛道上还有Avikus(现代重工的子公司)和Sea Machines等具有代表性的公司。

6.Patronus AI获1700万美元融资,致力于解决AI幻觉和版权问题

官方网站:网页链接

自动化AI评估平台Patronus AI近日获得1700万美元A轮融资,由Notable Capital领投,参与投资的还有Lightspeed Venture Partners、前DoorDash高管Gokul Rajaram、Factorial Capital、Datadog以及几位未透露姓名的科技高管,此轮融资使Patronus AI的总融资额达到2000万美元。

目前,对于大语言模型准确性和安全性的担忧是阻碍其在企业中广泛应用重要原因。例如,我们已经发现新闻网站CNET上由AI生成的文章文章错误百出,药物发现公司也因为AI的幻觉而撤回了研究论文。前Meta机器学习专家Anand Kannappan和Rebecca Qian看准了这个痛点,创建了这个AI模型自动化评估平台。

这个平台能够识别LLM输出中的幻觉、版权侵权和安全违规等错误。它使用专有AI对模型性能进行评分,通过对抗性示例对模型进行压力测试,并实现细致的基准测试—无需企业手动操作。

虽然还有一些其他初创公司如Credo AI、Weights & Biases和Robust Intelligence也在开发大模型评估工具,但Patronus认为其以研究为导向的方法和创始人的深厚专业知识使其与众不同。核心技术基于训练专用评估模型,可靠地揭示LLM可能失败的边缘案例。

这种策略已经赢得了包括汽车、教育、金融和软件等多个行业的多家财富500强公司的青睐,这些公司正在使用Patronus AI在其组织内“安全部署LLM”,尽管这家初创公司拒绝透露具体客户。

本文由阿尔法公社综合自多个信息源,并在ChatGPT的辅助下写作,封面图片由Hidream.ai的Pixeling(千象)生成。

更多精彩内容

关于阿尔法公社