高昂的计算成本,是限制AI应用大规模采用的重要瓶颈,无论是模型训练还是推理,都需要大量的算力,这也让“低成本”地进行AI创业变得困难。即便是大厂,仍然面临“单位经济学”算不平的问题,例如微软支持的GitHub CoPilot,每新增一个用户,就亏数十美元。

技术和应用的范式转换,总会催生计算和云服务的范式转换,互联网的崛起,催生了几大公有云厂商;AI的兴起,也会让一些专为AI应用搭建的云服务商脱颖而出,RunPod就是这个赛道的新秀。

近日,它获得英特尔资本和戴尔科技资本共同领投的2000万美元种子轮融资,Julien Chaummond、Nat Friedman和Adam Lewis等个人投资人也参与投资。

RunPod是转为AI打造的云计算服务平台,用于训练、部署和扩展AI模型。通过RunPod的两款核心产品—GPU Cloud和Serverless,开发者可以轻点几下就按需启动GPU实例,并为AI模型在生产环境中的推理创建自动扩展的API端点。

如果您对人工智能的新浪潮有兴趣,有见解,有创业意愿,欢迎扫码添加“阿尔法小助理”,备注您的“姓名+职位”,与我们深度连接。

从开发者社区中崛起的AI云平台

RunPod由Zhen Lu和Pardeep Singh联合创立,他们两位此前均是多媒体巨头Comcast的资深工程师,Zhen Lu还曾是匹兹堡大学的助理教授。

随着创业门槛的提高,“车库创业”似乎不那么流行了,很多团队都是从科研院所或者大公司出来创业,但是RunPod却恰是一个“车库创业”团队。他们在网络社区Reddit为网友和开发者们提供云服务,以让他们微调和运行Stable Diffusion模型。

以Reddit为起点,RunPod从一个副业项目,到Zhen和Pardeep全职投入,并组建了一个小而强大的团队,最后变成一个拥有多个全球基础设施合作伙伴的云平台。它发展了一个超过6万名开发者的社区,并推出了一个用于生产推理API的无服务器产品。在完成这些成就的时候,RunPod并没有融资。

由于自带开发者的基因,RunPod在用户增长和商业化上采取了自下而上的策略。它的联合创始人Zhen Lu回忆道:“最初是黑客和开发者社区,我们推出时,使用的是在地下室托管的GPU,发布在Reddit上,免费提供,用户是那些无法负担任何费用但愿意尝试AI的人。然后我们开始吸引那些为兼职工作使用它的高级用户,接着是他们的主要工作。大约一年前,我们开始渗透到中小企业和获得资金的初创公司。现在我们正开始进入更多的企业市场。”

让开发者低门槛的搭建AI应用

RunPod最主要的服务是GPU Cloud和Serverless。

GPU Cloud是专注于AI负载的云平台,Serverless是AI应用搭建平台。

RunPod与云巨头差异化竞争的优势就是它又快,又便宜,还很好用。

RunPod的第一个优势是灵活和低门槛。

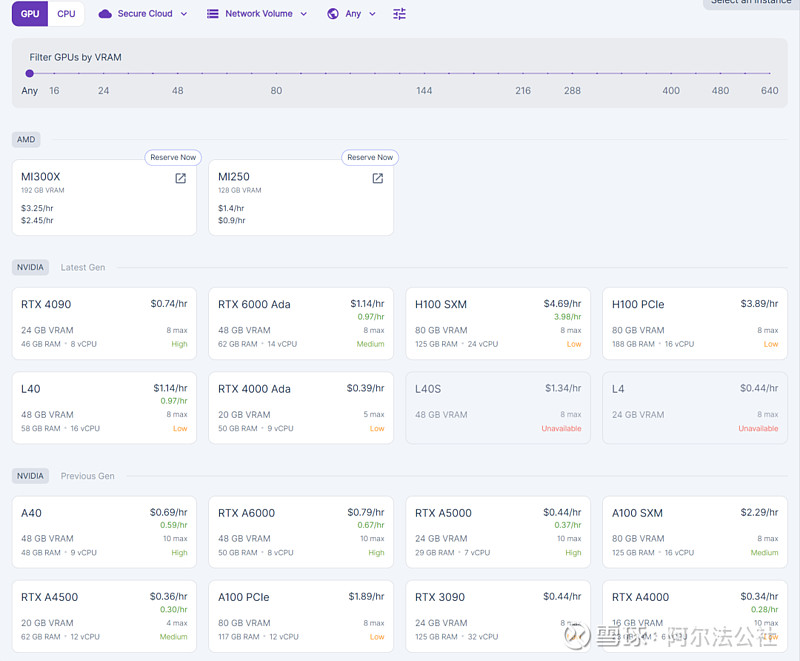

与Google等云巨头相比按月收费相比,它提供的GPU实例是按照小时收费的,更适合只需要做小型“实验”的开发者。

而且它的GPU实例不仅有H100等顶级GPU,还有A40和A6000,甚至4070Ti等更便宜的GPU。与H100每小时3.89美元的花费相比,A40只需要每小时0.69美元。

第二个优势是速度。

为了提升在RunPod平台上的推理速度和应用启动速度,他们做了很多优化。例如,使用他们的Faster-Whisper无服务器端点,运行速度比常规要快2-4倍,这同时也意味着它的价格会更低。

应用冷启动也是一个优化重点,RunPod的FlashBoot技术可以用于它所有的无服务器端点,在这项技术的加持下可以减少推理等GPU密集型任务的冷启动,目前最低的冷启动速度已经达到了500ms。

为了完成速度的提升,RunPod放弃了传统的Kubernetes,而是从头开始构建自己的编排层。因为Kubernetes更适合传统的工作负载,而对AI工作负载有局限性,它太复杂,会减慢开发周期,阻碍实验,成为AI采用的瓶颈。

第三个优势是便利性。

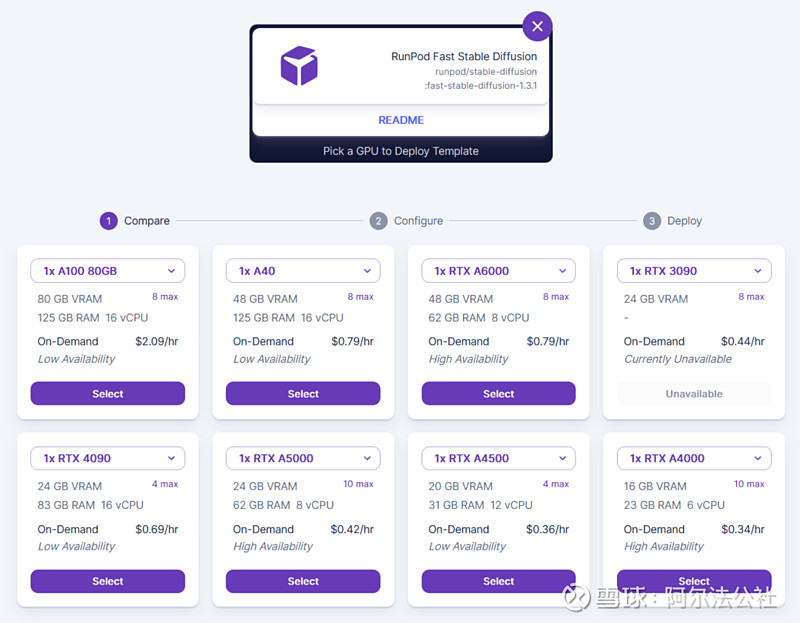

RunPod本身就是在Reddit社区以帮助开发者微调和运行Stable Diffusion模型起步,就以他们的Fast Stable Diffusion模板为例。

每当Stable Diffusion更新,开发者就可在平台上使用最新的模型,而且在这个模板上创建Stable Diffusion的实例非常简单,只需要简单几步就可完成,它还可运行带有捆绑Jupyter Notebook的Stable Diffusion UI界面。

AI采用仍在早期,基础设施创业空间巨大

在海外,看似OpenAI,Anthropic,谷歌,Meta等公司在大模型领域攻城略地,但AI显然还处于早期阶段,AI应用大规模普及的时期还没到来。在AI应用走向大规模应用的过程中,AI计算基础设施的规模也会同步扩大,尤其是AI的推理。

这对于创业公司当然是好消息。

但坏消息是,除了要面对Google Cloud,AWS等传统云计算巨头的竞争,NVIDIA也加入了战场。此前,NVIDIA的CFO Colette Kress在一份附带业绩的声明中表示,NVIDIA的DGX Cloud云计算业务,收入在三个月内增加了一倍多。

对于创业企业,怎么与云巨头,尤其是NVIDIA这样软硬件结合的公司差异化竞争,不但要做好让推理变得更快,训练和推理的成本更低这些基础性的工作,还得在体验上下功夫。

例如RunPod,它很懂开发者的需求,能够为开发者群体开发很多用起来更爽的功能,并从下到上的渗透进企业客户群体。

还有Together.ai,它拥有核心技术,能让AI模型的训练和推理速度增快数倍,而且能从模型层面进行革新,未来有望开发出比Transformer更好的模型架构。

在目前的中美创业环境下,中国需要一套自主可控的AI基础设施,无论是算力硬件,还是AI云计算平台。现在阿里云和火山引擎们利用自有的大模型及应用搭建工具建立生态,一定程度领先。

但是中国创业者的机会也很多,因为创业者们更懂需求也更专注,它们能够集中力量将产品做到极致,而大公司基本是大而全,做的是通用产品。无论是算力芯片,AI云平台,AI边缘云平台,我们认为中国的创业者都可以大胆地去探索。

本文由阿尔法公社原创。

更多精彩内容

关于阿尔法公社